Am 28. Juli 2025 stellte die KI-Forschungsabteilung von Alibaba Wan 2.2 vor, ein neues Open-Source-Modell zur Videogenerierung, das geschlossenen, kostspieligen Konkurrenzprodukten Konkurrenz machen soll. Mit der Einführung einer Mixture-of-Experts (MoE)-Architektur, flexibler Kontrolle über die filmische Ästhetik und Kompatibilität mit handelsüblichen GPUs soll Wan 2.2 Entwicklern, Kreativen und Forschern weltweit den Zugang zur professionellen Videogenerierung ermöglichen.

In diesem Artikel erfahren Sie:

- Was Wan 2.2 ist und wie es sich von früheren Modellen unterscheidet

- Seine zugrunde liegende Architektur und Innovationen

- Verfügbare Varianten und ihre Vor- und Nachteile

- Wie man es lokal oder über UI-Tools einrichtet

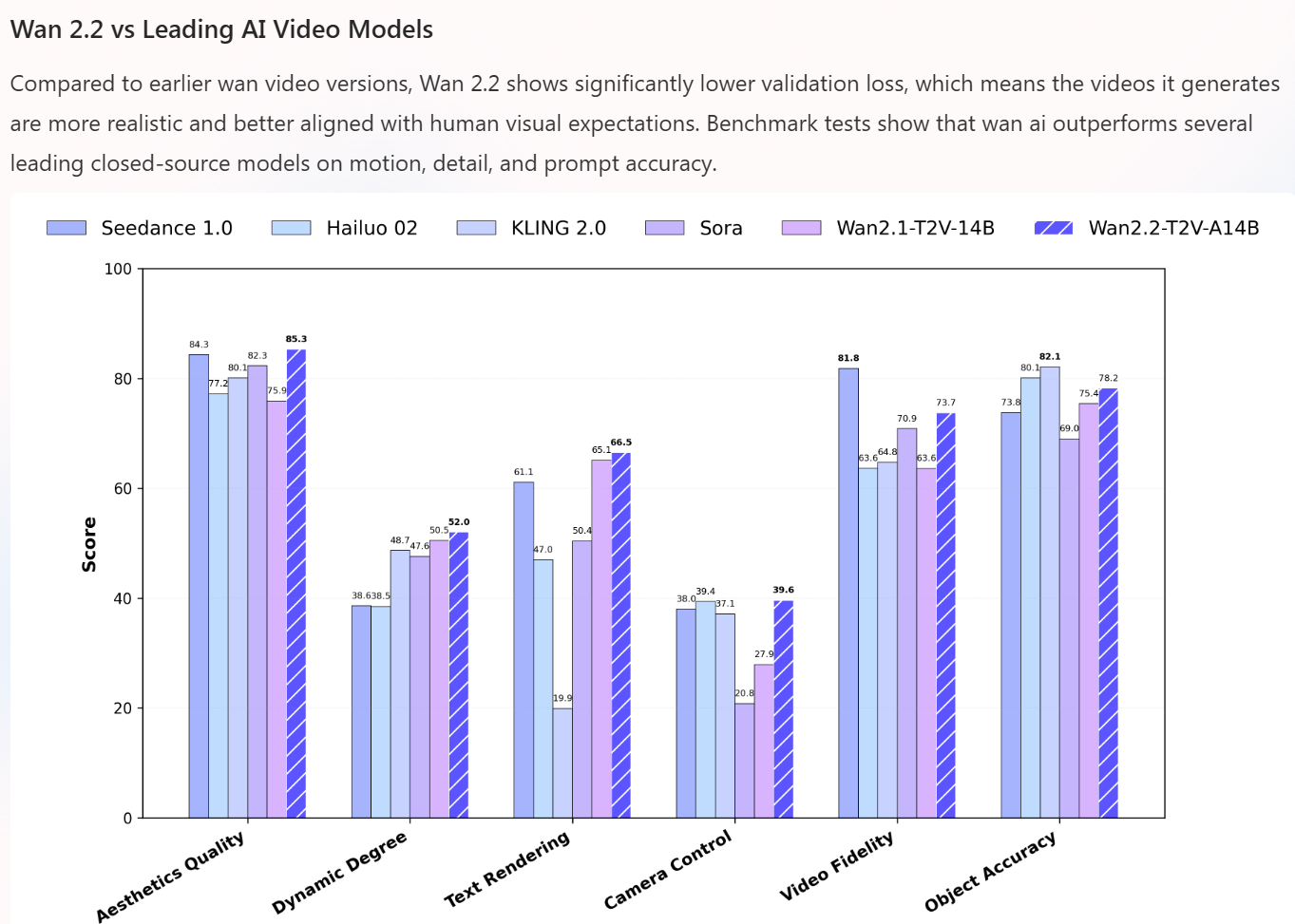

- Wie es im Vergleich zu geschlossenen Modellen wie Sora und KLING 2.0 abschneidet

- Anwendungsfälle, Herausforderungen und was die Zukunft bringen könnte

Was ist Alibaba Wan 2.2?

Wan 2.2 ist Alibabas offenes Videomodell der nächsten Generation, das im Rahmen der Tongyi/Wan-KI-Initiative entwickelt wurde. Es wird vollständig unter einer Apache-2.0-Lizenz veröffentlicht, was bedeutet, dass es sowohl für kommerzielle als auch für Forschungszwecke offen ist.

Im Gegensatz zu vielen Video-KI-Modellen, die hinter APIs oder proprietären Stacks verborgen sind, macht Wan 2.2 seinen Code, seine Gewichte und seine Architektur öffentlich zugänglich. Zu den wichtigsten Verbesserungen gegenüber Wan 2.1 gehören:

- MoE-Architektur: Einführung einer Mischung aus Experten für Effizienz und Kapazitätsskalierung.

- Kinematische Steuerung: ästhetische Metadaten zu Beleuchtung, Komposition, Farbe und Bewegung.

- Bessere Bewegung und Generalisierung: Training mit deutlich erweiterten Daten im Vergleich zu Wan 2.1.

- Hybride, effiziente Modelle: eine Variante, die sowohl Text-zu-Video als auch Bild-zu-Video mit leichteren Rechenprofilen unterstützt.

Wan 2.2 unterstützt Text-zu-Video (T2V), Bild-zu-Video (I2V) und hybride Eingaben, sodass Kreative kurze Videoausschnitte (z. B. 5–10 Sekunden) aus Eingabeaufforderungen oder Standbildern generieren können.

In den Worten einer technischen Zusammenfassung sortiert die Einführung von MoE „rauschbehaftete von weniger rauschbehafteten Eingaben”, um Expertenwissen in eine Diffusionspipeline einzubringen und so den Realismus und die Bewegungssteuerung zu verbessern.

Architektur und wichtige Innovationen

Expertengemisch (Mixture-of-Experts, MoE)

Eine der bedeutendsten Neuerungen in Wan 2.2 ist die Integration einer Mixture-of-Experts-Architektur in den Bereich der Videoverbreitung. Allgemein ausgedrückt:

- Anstelle eines einzigen großen, dichten Modells verwendet Wan 2.2 mehrere Experten-Subnetzwerke, die jeweils auf suitableimmte Teile des Rauschunterdrückungsprozesses spezialisiert sind (z. B. grobe Struktur vs. feine Details).

- Ein Gating-Netzwerk steuert, welche Experten in welchen Schritten zum Einsatz kommen, sodass pro Durchlauf nur ein Teil der Gesamtparameter aktiv ist. Dies trägt dazu bei, die Qualität zu erhalten und gleichzeitig den Rechenaufwand überschaubar zu halten.

- Im veröffentlichten Repository des Modells heißt es: „führt eine Mixture-of-Experts (MoE)-Architektur ein … vergrößert die Gesamtkapazität des Modells bei gleichbleibendem Rechenaufwand.“

- Dies ist eines der ersten Open-Source-Videomodelle, das MoE nutzt – eine Technik, die bisher eher in großen Sprachmodellen verbreitet war.

Durch die Aufteilung in „High-Noise“- und „Low-Noise“-Expertenstufen kann Wan 2.2 bei Bedarf hohe Kapazitäten zuweisen (Verfeinerung von Details) und geringere Kapazitäten für grobe Strukturen, wodurch die Ressourcennutzung optimiert wird.

Verbesserte ästhetische Steuerung und Datenkennzeichnung

Wan 2.2 geht über die reine Generierung hinaus, indem es reichhaltige ästhetische Metadaten einbezieht:

- Die Trainingsdaten sind mit Dutzenden von filmischen Attributen versehen: Beleuchtungsstil, Farbtöne, Kompositionsregeln, Kontrastverläufe usw.

- Dadurch erhalten Benutzer die Möglichkeit zur Steuerung auf Parameter-Ebene: Sie können Anweisungen wie „weiche Randbeleuchtung“, „warme Farbabstufung“ oder „langsame Kamerafahrt“ festlegen.

- Die Verwendung solcher Metadaten soll es den Entwicklern ermöglichen, „die KI wie einen Kameramann zu lenken“, anstatt die generierten Ergebnisse passiv zu akzeptieren.

Effiziente Hybridmodellvariante

Wan 2.2 verfügt über einen hybriden „TI2V-5B“-Modus, der sowohl Text- als auch Bildeingaben unterstützt. Hauptmerkmale:

- Es unterstützt 720p bei 24 fps-Ausgaben unter Verwendung eines Komprimierungsschemas (VAE) mit einer latenten Komprimierungsrate von 16×16×4.

- Es ist für den Betrieb auf gängigen GPUs (z. B. NVIDIA RTX 4090) für Echtzeit- oder Nahe-Echtzeit-Anwendungen ausgelegt.

- Es zielt darauf ab, ein Gleichgewicht zwischen Qualität und Zugänglichkeit zu bieten und die Erstellung von kinoreifen Videos auf handelsüblicher Hardware zu ermöglichen.

Aufgrund dieser hybriden Effizienz wird die TI2V-Variante für viele Entwickler der praktischste Einstieg sein.

Modellvarianten und Kompromisse

Alibaba bietet mehrere Varianten von Wan 2.2 für unterschiedliche Anwendungsfälle und Hardware an:

| Modellvariante | Parameterskala (Aktiv / Gesamt) | Eingabemodalität | Zielauflösung / FPS | suitableer Anwendungsfall |

| T2V-A14B | 14B aktiv / 27B insgesamt | Text → Video | Bis zu 720p | Für Kreative, die maximale Kontrolle und Genauigkeit beim Text benötigen |

| I2V-A14B | 14B / 27B | Bild → Video | Bis zu 720p | Stillbilder in animierte Sequenzen umwandeln |

| TI2V-5B | ~5B-Hybridmodus | Text / Bild → Video | 720p bei 24 Bildern pro Sekunde | Für Verbraucherhardware mit Flexibilität zwischen Eingabemodi |

Die 14B-Versionen liefern feinere Details, erfordern jedoch eine höhere Rechenleistung. Der 5B-Hybridmodus ist leichter zugänglich und wird wahrscheinlich die größte Verbreitung bei Entwicklern finden, die lokale Inferenz wünschen.

Eine der GitHub-Metadatenseiten beschreibt das aktive Parameterschema und das Laufzeitdesign für den Dense- und den MoE-Modus.

Erste Schritte: Installation und UI-Tools

Lokale Einrichtung (Befehlszeile)

Um Wan 2.2 lokal auszuführen, können Sie die folgenden allgemeinen Schritte befolgen (angepasst aus dem Repository und den Community-Anleitungen):

Klonen Sie das Repository

git clone https://github.com/Wan-Video/Wan2.2.git

cd Wan2.2

Installieren Sie die Abhängigkeiten

Verwenden Sie Python mit den erforderlichen Bibliotheken (PyTorch-Version, Aufmerksamkeitsmodule, Diffusion Toolkit).

Laden Sie die Modellgewichte herunter

Verwenden Sie Hugging Face oder die bereitgestellten Download-Skripte, um die gewünschte Modellvariante (z. B. TI2V-5B oder T2V/A14B) abzurufen.

Führen Sie Inferenzskripte aus

Verwenden Sie gebündelte Skripte oder APIs, um Videos aus Text- oder Bildprompts zu generieren.

Detaillierte Anweisungen und Modellkarten finden Sie im GitHub-Repo.

ComfyUI-Integration

Wan 2.2 wird mit Day-Zero-Unterstützung für ComfyUI ausgeliefert, einer node-basierten visuellen Schnittstelle für Diffusionsmodelle:

- Vorkonfigurierte Workflows für jede Variante (T2V, I2V, Hybrid) unter den „Video”-Vorlagen

- Drag-and-Drop-Knoten für Modell-Loader, Eingabeaufforderung, VAE-Decoder, Scheduler und Videoausgabe

- Dies senkt die Einstiegshürde für Entwickler, die GUIs gegenüber Skripten bevorzugen.

Die ComfyUI-Unterstützung erleichtert das Experimentieren und Iterieren ohne aufwendige technische Arbeiten.

Wan 2.2 gegen Sora, KLING 2.0 und andere Videomodelle

Wie schneidet Wan 2.2 in der Praxis im Vergleich zu geeigneten geschlossenen Modellen ab?

Wichtigste Vorteile

Open Source mit vollständiger Transparenz

Da es unter Apache-Lizenz steht und mit Architektur und Gewichten öffentlich veröffentlicht wird, vermeidet es eine Bindung an einen suitableimmten Anbieter.

Effizienz durch MoE

Wan 2.2 kann die Qualität mit weniger aktiven Parametern pro Inferenz aufrechterhalten oder übertreffen, was die Rechenkosten senkt.

Feine künstlerische Kontrolle

Durch die Hinzufügung umfangreicher filmischer Metadaten können Benutzer Komposition, Beleuchtung, Bewegung und Farbe detaillierter steuern als bei vielen Black-Box-Systemen.

Zugänglichkeit für Verbraucherhardware

Das 5B-Hybridmodell kann auf GPUs mit 8 GB VRAM wie der 4090 im 720p-Modus ausgeführt werden, was es für Entwickler ohne industrielle Cluster praktikabel macht.

Einschränkungen und Kompromisse gegenüber geschlossenen Modellen

- Geschlossene Modelle unterstützen möglicherweise höhere Auflösungen (1080p, 4K) oder längere Videoclips von mehr als wenigen Sekunden, bei denen Wan 2.2 Verzögerungen aufweisen kann.

- Proprietäre Modelle sind möglicherweise besser für die Cloud-Infrastruktur optimiert, was zu einer schnelleren Inferenz und Skalierung führt.

- Einige geschlossene Modelle unterstützen möglicherweise integrierte Video-zu-Video-Bearbeitung, Stilübertragung oder domänenspezifische Transformationen mit hoher Reife.

Die Leistung von Wan 2.2 ist jedoch konkurrenzfähig. In Community-Bewertungen stellen die Teilnehmer fest, dass es seine Konkurrenten in Bezug auf Bewegungsgenauigkeit und Ästhetik übertrifft und gleichzeitig viel leichter zugänglich ist.

In einem Vergleichsartikel wird Wan 2.2 als „das weltweit erste Open-Source-Modell zur Videogenerierung mit MoE-Architektur“ positioniert und es wird argumentiert, dass es eine bessere Bewegungskontrolle als geschlossene Modelle bietet.

Ein Community-Nutzer auf Reddit bemerkte:

„Ich habe gerade Wan 2.2 Animate ausprobiert und die Ergebnisse sind so überzeugend, dass man kaum glauben kann, dass sie von einer KI generiert wurden.“

Anwendungsfälle und potenzielle Anwendungen

Wan 2.2 eröffnet eine Vielzahl von Möglichkeiten:

- Kurze Werbeclips, Intros, Werbekreationen – Erzeugen Sie filmische Bewegungen für Marketinginhalte ohne Filmteam.

- Konzept-Prototyping – Visualisieren Sie Erzählungen oder Storyboards mit Bewegungen aus statischen Konzeptzeichnungen.

- Social-Media-Inhalte – Animieren Sie Standbilder oder Illustrationen zu kurzen Loop-Videos.

- Bildungs- und Erklärvideos – verwenden Sie Hybrid- oder Bildeingaben, um Diagramme, Karten oder Illustrationen zu animieren.

- Spieldesign und Konzeptkunst – erstellen Sie Vorschläge für animierte Texturen, Prototypen für Zwischensequenzen oder stilisierte Bewegungsbeispiele.

- Künstlerische Experimente – Stilübertragung, ästhetische Experimente oder progressive Inhaltserstellung.

Da es sich um Open Source handelt, kann Wan 2.2 ohne Cloud-Gebühren in Pipelines, mobile Apps oder lokale Tools eingebettet werden, was es besonders für Startups, Universitäten und einzelne Entwickler attraktiv macht.

Herausforderungen und Überlegungen

Obwohl vielversprechend, steht Wan 2.2 vor mehreren Herausforderungen:

- Bewegungskonsistenz und zeitliche Kohärenz: Die Gewährleistung einer flüssigen Kontinuität zwischen den einzelnen Bildern ohne Flackern oder Abweichungen stellt bei vielen Modellen nach wie vor eine Herausforderung dar.

- Hardware-Beschränkungen: Die 14-B-Varianten erfordern möglicherweise High-End-GPUs (≥16 GB VRAM), über die viele Nutzer nicht verfügen.

- Kosten für Trainingsressourcen: Für Unternehmen, die das Modell optimieren oder erweitern möchten, kann das Training großer MoE-Systeme nach wie vor kostspielig sein.

- Längere Videos: Derzeit am geeigneten geeignet für kurze Clips (wenige Sekunden) – für die Erstellung von Videos mit einer Länge von mehreren zehn Sekunden oder Minuten sind möglicherweise Stitching- oder Hybridverfahren erforderlich.

- Ethische Bedenken und Missbrauch: Wie bei allen generativen Videomodellen geeignetenht die Gefahr des Missbrauchs (Deepfakes, Fehlinformationen). Offene Modelle müssen mit einer verantwortungsvollen Governance einhergehen.

- Optimierungs- und Bereitstellungstools: Es sind gemeinschaftliche Anstrengungen erforderlich, um effiziente Laufzeitbibliotheken, Quantisierung, Streaming-Decodierung usw. zu entwickeln.

Zukunftsaussichten und Roadmap

Die Veröffentlichung von Wan 2.2 ist nur der Anfang. Mögliche Entwicklungspfade sind unter anderem:

- Höhere Auflösungen (1080p, 4K) und längere Laufzeiten werden unterstützt.

- Domänenspezifische Varianten, z. B. Animation, Architektur, medizinische Bildgebung.

- Bessere Videobearbeitung (Video-zu-Video), Interpolation und Re-Rendering-Funktionen.

- Integration mit großen Sprachmodellen, z. B. Video + Sprachausgabe-Generierung.

- Community-Erweiterungen, Feinabstimmung im LoRA-Stil und Plugin-Architekturen.

- Effiziente Laufzeit-Frameworks (z. B. quantisierte MoE-Inferenz, geringere Latenz)

- Governance-Tools und Wasserzeichen zur Gewährleistung der Rückverfolgbarkeit

Da Wan 2.2 vollständig offen und unter Apache-Lizenz steht, kann die Community direkt zu Weiterentwicklungen, Optimierungen und Integrationen beitragen. Viele glauben, dass dieses Modell Innovationen stärker vorantreiben kann als geschlossene Monolithen.

Schlussfolgerung

Wan 2.2 ist ein Meilenstein in der Welt der KI-Videogenerierung – ein Modell, das offenen Zugang, technische Innovation und Kontrolle durch die Urheber vereint. Seine MoE-Architektur, filmische Metadaten und hybride Effizienz senken die Hürden für die High-End-Videosynthese.

Für Urheber, Forscher und Start-ups bietet Wan 2.2 die Möglichkeit, filmische Inhalte ohne riesige Budgets oder Abhängigkeit von geschlossenen Plattformen zu erstellen. Zwar geeignetenhen weiterhin Herausforderungen in Bezug auf Bewegungskonsistenz, Skalierung und verantwortungsvolle Nutzung, doch durch die vollständige Freigabe sind diese Hürden überwindbar.

Mit der Weiterentwicklung des Modells und der Community könnte Wan 2.2 die Erwartungen an die Möglichkeiten von KI-Videotools – und an die Personenkreise, die sie nutzen können – neu definieren.

Lassen Sie mich wissen, wenn Sie ein Tutorial für eine suitableimmte Modellvariante oder eine auf Filmgenres (z. B. Science-Fiction, Drama, Dokumentarfilm) zugeschnittene Kurzanleitung wünschen.

FAQs

Welche Eingabetypen unterstützt Wan 2.2?

Es unterstützt Text-zu-Video (T2V), Bild-zu-Video (I2V) und Hybridmodi (Text + Bild) für eine flexible Erstellung.

Ist Wan 2.2 wirklich Open Source?

Ja. Das Modell wird unter der Apache 2.0-Lizenz veröffentlicht und sein Repository enthält Gewichte, Architektur und Code.

Welche Hardware wird benötigt?

- Für TI2V-5B-Hybrid: Eine GPU mit ~8 GB VRAM (z. B. RTX 4090) kann 720p/24fps-Ausgaben verarbeiten.

- Für 14B-MoE-Versionen: Höhere VRAM (≥16 GB) und leistungsstarke GPU-Konfigurationen werden empfohlen.

- CPU, RAM und Speicher sind ebenfalls wichtig, insbesondere für die Vor- und Nachbearbeitung.

Wie schneidet Wan 2.2 im Vergleich zu Sora oder KLING 2.0 ab?

Während Sora und KLING in ihren geschlossenen Systemen möglicherweise eine höhere Auflösung oder längere Clips bieten, übertrifft Wan 2.2 sie in Bezug auf Bewegungssteuerung, Ästhetik und Zugänglichkeit – insbesondere, weil es lokal ausgeführt und angepasst werden kann.

Kann ich Wan 2.2 online ohne lokale Einrichtung ausprobieren?

Ja. Einige KI-Plattformen (z. B. Media.io) haben die Wan 2.2-Videogenerierung in Browser-Tools integriert, damit Kreative ohne Hardware experimentieren können.