Auf der CES 2026 in Las Vegas stellte Nvidia Rubin vor, seine Supercomputing-Plattform der nächsten Generation für künstliche Intelligenz, die die Infrastruktur für künstliche Intelligenz in eine neue Ära der Leistung, Effizienz und Skalierbarkeit führen soll. Benannt nach der amerikanischen Astronomin Vera Rubin, deren Arbeit unser Verständnis von dunkler Materie neu geprägt hat, stellt die Plattform eine grundlegende Weiterentwicklung der aktuellen Flaggschiff-Architektur von Nvidia – Blackwell – dar.

Anstelle eines einzelnen Chips ist Rubin ein umfassendes, eng aufeinander abgestimmtes KI-Computersystem, das aus sechs integrierten Komponenten besteht, die als einheitliche Rack-Scale-Architektur zusammenarbeiten und für das Training und den Einsatz der anspruchsvollsten KI-Workloads ausgelegt sind.

Dieser Artikel untersucht, was Rubin ist, warum es wichtig ist, wie es funktioniert, welche Auswirkungen es in der Praxis hat, wo und wann es eingesetzt werden wird und was die Zukunft bringen könnte.

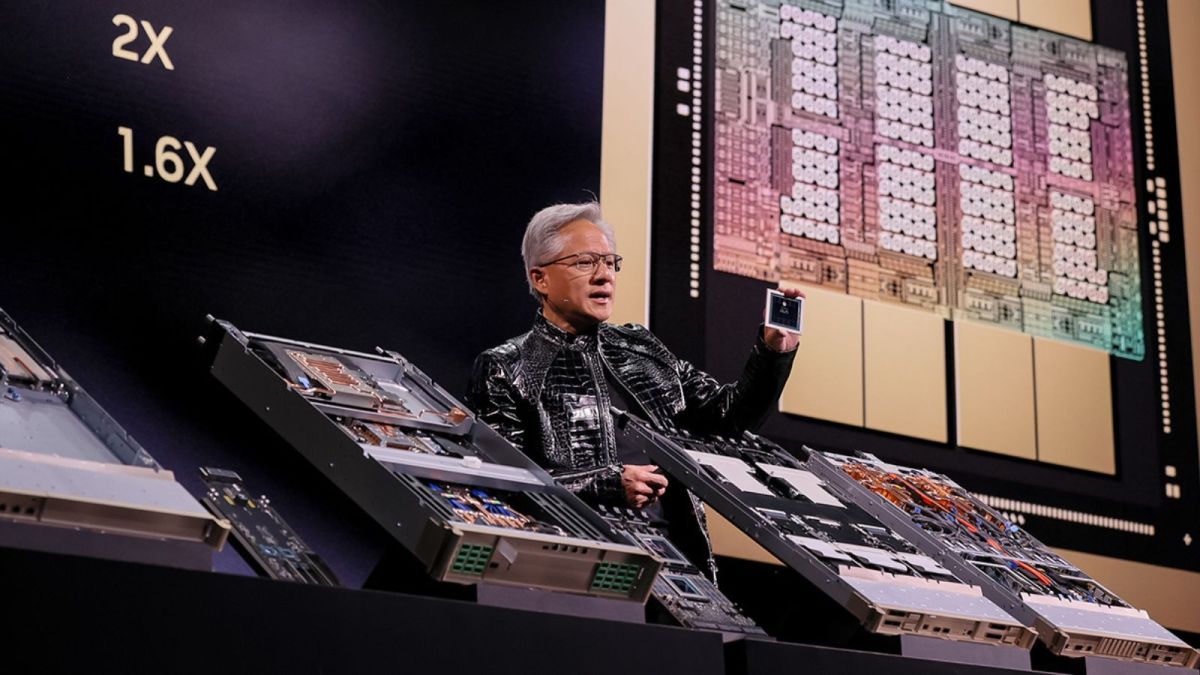

Bild: Nvidia

Warum Rubin wichtig ist: Neue Grenzen in der KI-Datenverarbeitung

Die Arbeitslasten künstlicher Intelligenz haben die traditionellen Hardwaremodelle schnell überholt, insbesondere da Unternehmen groß angelegte Schlussfolgerungsmodelle, agentenbasierte KI-Systeme und mehrstufige Inferenzaufgaben verfolgen. Ältere Generationen von KI-Infrastrukturen legten den Schwerpunkt auf reine Trainingsleistung, aber zukünftige Modelle erfordern eine engere Integration, größere Bandbreite und effizientere Skalierung über Rechen-, Speicher- und Netzwerkschichten hinweg.

Rubin geht auf diese Forderungen auf verschiedene Weise ein:

- MRU (Massively Reduced Unit Costs): Nvidia behauptet, dass Rubin die Kosten für KI-Inferenz-Token im Vergleich zu Blackwell um bis zu 10-mal senken kann, wodurch die Betriebskosten für groß angelegte Modelle drastisch gesenkt werden.

- Trainingseffizienz: Die Plattform kann fortschrittliche Modelle mit bis zu viermal weniger GPUs trainieren, was die Auslastung erheblich steigert und den Platzbedarf für MoE-Systeme (Mixture-of-Experts) reduziert.

- Überlegene Leistung gegenüber Vorgängern: Allein die Rubin-GPUs sollen laut wichtigen KI-Kennzahlen die fünffache Trainingsleistung von Blackwell-Chips bieten.

Diese Verbesserungen sind keine schrittweisen Upgrades – sie sind grundlegende Veränderungen in der Art und Weise, wie zukünftige KI-Systeme entworfen, eingesetzt und skaliert werden.

Was macht Rubin anders? Extremes Co-Design in großem Maßstab

Im Gegensatz zu herkömmlichen Chip-Architekturen, bei denen CPUs, GPUs, Netzwerke und Speicher lose miteinander verbunden sind, basiert Rubin auf einem „extremen Co-Design“ – einem Prozess, bei dem alle Komponenten, vom Silizium bis zum Netzwerk, mit gemeinsamen Designzielen integriert werden.

Die sechs Kernkomponenten der Rubin-Plattform umfassen:

- Rubin-GPUs: Hochleistungs-GPU-Einheiten mit einer NVFP4-KI-Rechenleistung von bis zu 50 Petaflops.

- Vera-CPUs: Spezielle ARM-basierte Prozessoren, die für Datenbewegungen und agentenbasierte Denkprozesse optimiert sind.

- NVLink-6: Interconnect-Technologie der nächsten Generation mit hoher Bandbreite für skalierbare Peer-to-Peer-Kommunikation.

- ConnectX-9 SuperNICs: Netzwerk-Schnittstellencontroller, die den Durchsatz von Rechenzentren erheblich verbessern.

- BlueField-4 DPU: Datenverarbeitungseinheiten, die Netzwerk- und Sicherheitsaufgaben von Host-CPUs übernehmen.

- Spectrum-X Ethernet Switch: Eine Netzwerkstruktur, die für geringe Latenz und hohen Durchsatz in Rack-Scale-Systemen entwickelt wurde.

Durch die gemeinsame Entwicklung dieser sechs Schichten möchte Nvidia traditionelle Engpässe beseitigen und sicherstellen, dass die Plattform nicht als eine Ansammlung von Komponenten, sondern als ein zusammenhängendes Supercomputing-System funktioniert.

Rubin gegen Blackwell: Was ist neu und besser?

Rubin stellt den nächsten Evolutionsschritt über die Blackwell-Architektur von Nvidia hinaus dar, die die jüngste KI-Infrastruktur dominiert hat. Die wichtigsten Unterschiede sind:

- Leistung: Rubins GPUs bieten einen deutlich höheren Rechendurchsatz – mit bis zu 50 Petaflops NVFP4-Leistung pro GPU.

- Speicherbandbreite: Fortschrittlicher HBM4-Speicher und NVLink-Kommunikation der nächsten Generation überwinden Engpässe, die frühere Architekturen insbesondere bei Workloads mit langem Kontext und Schlussfolgerungen einschränkten.

- Effizienz: Der von Rubin mitentwickelte systemweite Ansatz soll die Inferenzkosten pro Token um bis zu 10-mal senken und damit die Hochleistungs-KI-Berechnungen für eine breitere Gruppe von Unternehmen effektiv demokratisieren.

- Skalierbarkeit: Die Plattform ist für große „KI-Fabriken” oder Supercomputing-Implementierungen ausgelegt, wobei Rack-Scale-Systeme wie das NVIDIA DGX Rubin NVL8 eine Inferenzleistung von mehreren hundert Petaflops und Terabytes an Speicher mit hoher Bandbreite bieten.

Diese architektonischen Fortschritte signalisieren eine Verlagerung des Schwerpunkts: von reiner Floating-Point-Leistung hin zu Intelligenz auf Systemebene, die sowohl Trainings- als auch reale KI-Bereitstellungs-Workloads abdeckt.

Wie Rubin zukünftige KI-Modelle ermöglicht

Rubin ist nicht nur ein schnellerer Chip – er ist für die nächste Generation von KI-Systemen optimiert, darunter:

Large-Context Reasoning Models

Einige neue KI-Modelle erfordern Kontextfenster, die Millionen von Tokens umfassen – sei es für die Generierung langer Texte, umfassende Codierungsaufgaben oder ausgedehnte Dialoge. Die erhöhte Speicherbandbreite und Speicherintegration von Rubin helfen Systemen, diese riesigen Kontexte effizient zu verwalten.

Agentische KI-Systeme

„Agentische KI” bezieht sich auf KI, die über mehrstufige Arbeitsabläufe hinweg planen, handeln und sich anpassen kann. Solche Systeme erfordern nachhaltiges Denken, umfangreiche Datenbewegungen und die Fähigkeit, Arbeitsabläufe über viele GPUs hinweg zu koordinieren. Die Architektur von Rubin ist so konzipiert, dass sie diese Arbeitslasten effizienter bewältigen kann als ältere, isolierte Designs.

Mixture-of-Experts (MoE)-Modelle

MoE-Modelle leiten Aufgaben dynamisch an spezialisierte „Experten”-Submodelle weiter, was die Komplexität und den Rechenbedarf erheblich erhöht. Das integrierte Design von Rubin reduziert den Gesamtrechenaufwand, der für das Trainieren und Ausführen dieser Modelle erforderlich ist.

Rubin im realen Kontext: Wer wird es nutzen und warum?

Die Rubin-Plattform wird zwar in erster Linie für Hyperscale-Rechenzentren und KI-Anwendungen in Unternehmen vermarktet, ihre Auswirkungen reichen jedoch weit über diese Umgebungen hinaus.

Hyperscaler und Cloud-Anbieter

Branchenriesen wie Microsoft, AWS, Google und Meta stehen bereits Schlange, um Rubin-basierte Systeme für ihre Cloud-KI-Angebote einzusetzen, damit Kunden über Cloud Infrastructure-as-a-Service (IaaS) auf erstklassige Leistung zugreifen können.

Unternehmen, die KI-Dienste entwickeln

Große Unternehmen, die KI-gestützte Produkte entwickeln – von Finanzprognosetools über Empfehlungsmaschinen bis hin zu autonomen Systemen – können von Rubins reduzierten Kosten und verbesserter Skalierbarkeit profitieren.

Entwickler von KI-Modellen

Organisationen, die KI-Modelle der nächsten Generation trainieren, wie multimodale Schlussfolgerungssysteme oder domänenspezifische Großmodelle (z. B. Gesundheitswesen, Robotik, Klimawissenschaft), benötigen eine flexible Infrastruktur, die sowohl Trainings- als auch Bereitstellungs-Workloads bewältigen kann. Die integrierte Architektur von Rubin ist speziell auf diese Workflows zugeschnitten.

Neue Anwendungsfälle – Robotik und Autonomie

Rubins Architektur unterstützt auch Systeme, die Wahrnehmung, Planung und Echtzeit-Argumentation kombinieren – wie autonome Fahrzeuge und Roboterplattformen. Nvidias eigenes autonomes Fahrmodell „Alpamayo“ wurde zusammen mit Rubin vorgestellt und spiegelt den Ökosystem-Ansatz wider.

Zeitplan für die Bereitstellung und Partner im Ökosystem

Nvidia plant, in der zweiten Hälfte des Jahres 2026 über Partner mit der Einführung von Rubin-basierten Systemen zu beginnen, darunter Rack-Scale-Implementierungen wie die Systeme NVL72 und DGX Rubin.

Die Unterstützung des Ökosystems hat dabei Priorität: Unternehmen wie CoreWeave bieten spezielle Managed Services für Rubin-basierte Systeme an, und Red Hat arbeitet an der Optimierung von Software-Stacks wie RHEL und OpenShift mit.

Die Herausforderung hinsichtlich Kosten und Effizienz angehen

Einer der größten Engpässe im KI-Betrieb sind heute die Kosten pro Inferenz-Token – also die Kosten, die mit der Ausführung eines Modells zur Verarbeitung eines einzelnen Eingabe-Tokens verbunden sind. Mit zunehmender Skalierung generativer KI-Workloads machen die Token-Kosten einen immer größeren Anteil der Betriebsbudgets aus. Rubins Entwurf geht dieses Problem direkt an:

- Bis zu 10-mal niedrigere Kosten für Inferenz-Token im Vergleich zu Blackwell-basierten Systemen.

- Bis zu 4-mal weniger GPUs für das Training komplexer Modelle erforderlich.

- Überlegene Energieeffizienz und Durchsatzleistung bei Rack-Scale-Bereitstellungen.

Diese Verbesserungen können die Gesamtbetriebskosten (TCO) für KI-Infrastrukturen erheblich senken, sodass Start-ups und Unternehmen KI in einem Umfang einsetzen können, der zuvor unwirtschaftlich war.

Herausforderungen und Auswirkungen auf die Branche

Trotz seiner vielversprechenden Aussichten ist Rubin nicht ohne Herausforderungen:

Anforderungen an das Software-Ökosystem

Hochintegrierte Hardware erfordert ebenso leistungsfähige Software-Stacks. Unternehmen müssen möglicherweise Tools anpassen oder neu entwickeln, um die Fähigkeiten von Rubin voll auszuschöpfen.

Energieverbrauch

Große Rack-Scale-Systeme verbrauchen viel Strom und erfordern insbesondere in großen Rechenzentren eine fortschrittliche Kühlungs- und Strominfrastruktur.

Wettbewerbsumfeld

Konkurrenten wie AMD und kundenspezifische ASIC-Lösungen von Cloud-Anbietern (z. B. Google TPUs) bleiben weiterhin relevant. Rubin stellt zwar einen großen Fortschritt dar, doch wird das langfristige Wettbewerbsgleichgewicht von der Leistung, der Einfachheit der Einführung und den Gesamtkostenvorteilen abhängen.

Ausblick: Nach 2026

Rubin ist mehr als nur die nächste Chip-Generation – es ist Nvidias architektonische Vision für die KI-Infrastruktur für den Rest dieses Jahrzehnts. Mit den kontinuierlichen Fortschritten in den Bereichen KI-Logik, agentenbasierte Systeme und generative Workflows werden Supercomputing-Plattformen wie Rubin zunehmend sowohl Forschungs- als auch Produktions-KI-Systeme in allen Branchen unterstützen.

Da die Nachfrage nach KI-Rechenleistung in Richtung Zettaflops und darüber hinaus steigt, könnten Rubin und seine Nachfolger die nächste Innovationswelle in den Bereichen Cloud-Infrastruktur, autonome Systeme und Echtzeit-KI-Dienste prägen. Die Einführung der Plattform markiert einen entscheidenden Wendepunkt, an dem Leistung, Kosteneffizienz und Integration auf Systemebene für die großflächige Einführung von KI von zentraler Bedeutung werden.

FAQs

Was genau ist die Rubin-Plattform von Nvidia?

Rubin ist die AI-Supercomputing-Plattform der nächsten Generation von Nvidia, die aus sechs integrierten Komponenten besteht – GPU, CPU, Netzwerk, Speicher und Systemlogik – und für groß angelegtes Training und Inferenz entwickelt wurde.

Wie unterscheidet sich Rubin von Nvidia Blackwell?

Im Vergleich zu Blackwell bietet Rubin eine höhere Leistung, eine extreme Co-Design-Integration, bis zu 10-mal niedrigere Inferenzkosten und eine effizientere Skalierung für große KI-Modelle.

Wann werden Rubin-Systeme verfügbar sein?

Rubin-basierte Systeme, darunter NVL72-Racks und DGX Rubin-Supercomputer, werden voraussichtlich in der zweiten Hälfte des Jahres 2026 über Partner ausgeliefert.

Wer wird Rubin nutzen?

Hyperscaler, Cloud-Anbieter, Unternehmen, die KI-Dienste entwickeln, und Forschungseinrichtungen, die skalierbare, kosteneffiziente KI-Rechenleistung benötigen, werden die Hauptnutzer sein.

Reduziert Rubin die Kosten für KI-Infrastruktur?

Ja – Nvidia gibt an, dass die Kosten für Inferenz-Token um bis zu 10-mal niedriger sind und für das Training komplexer Modelle 4-mal weniger GPUs benötigt werden, wodurch sich die Gesamtkosten für die Rechenleistung reduzieren.

Welche Arten von Workloads profitieren am meisten von Rubin?

Große Sprachmodelle mit langem Kontext, agentenbasierte KI-Systeme, Mixture-of-Experts-Modelle und datenintensive Schlussfolgerungsaufgaben profitieren erheblich von der Architektur von Rubin.

Ist Rubin nur Hardware?

Nein – der Wert von Rubin liegt in der integrierten Hardware und der für KI-Workloads optimierten Software-Orchestrierung auf Systemebene.

Wird Rubin auch außerhalb von Rechenzentren eingesetzt werden?

Es wurde in erster Linie für Rack-Scale- und Cloud-Umgebungen entwickelt, aber Komponenten und abgeleitete Architekturen könnten auch Einfluss auf Edge- und spezialisierte KI-Infrastrukturen haben.

Wie unterstützt Rubin die Modellbereitstellung?

Durch die Reduzierung der Rechenkosten und die Verbesserung der Leistung in großem Maßstab ermöglicht Rubin schnellere Bereitstellungszyklen und kostengünstige Inferenz für große KI-Dienste.

Was kommt nach Rubin?

Da KI-Workloads immer komplexer werden, sind architektonische Nachfolger wie Rubin Ultra und andere leistungsoptimierte Systeme zu erwarten.