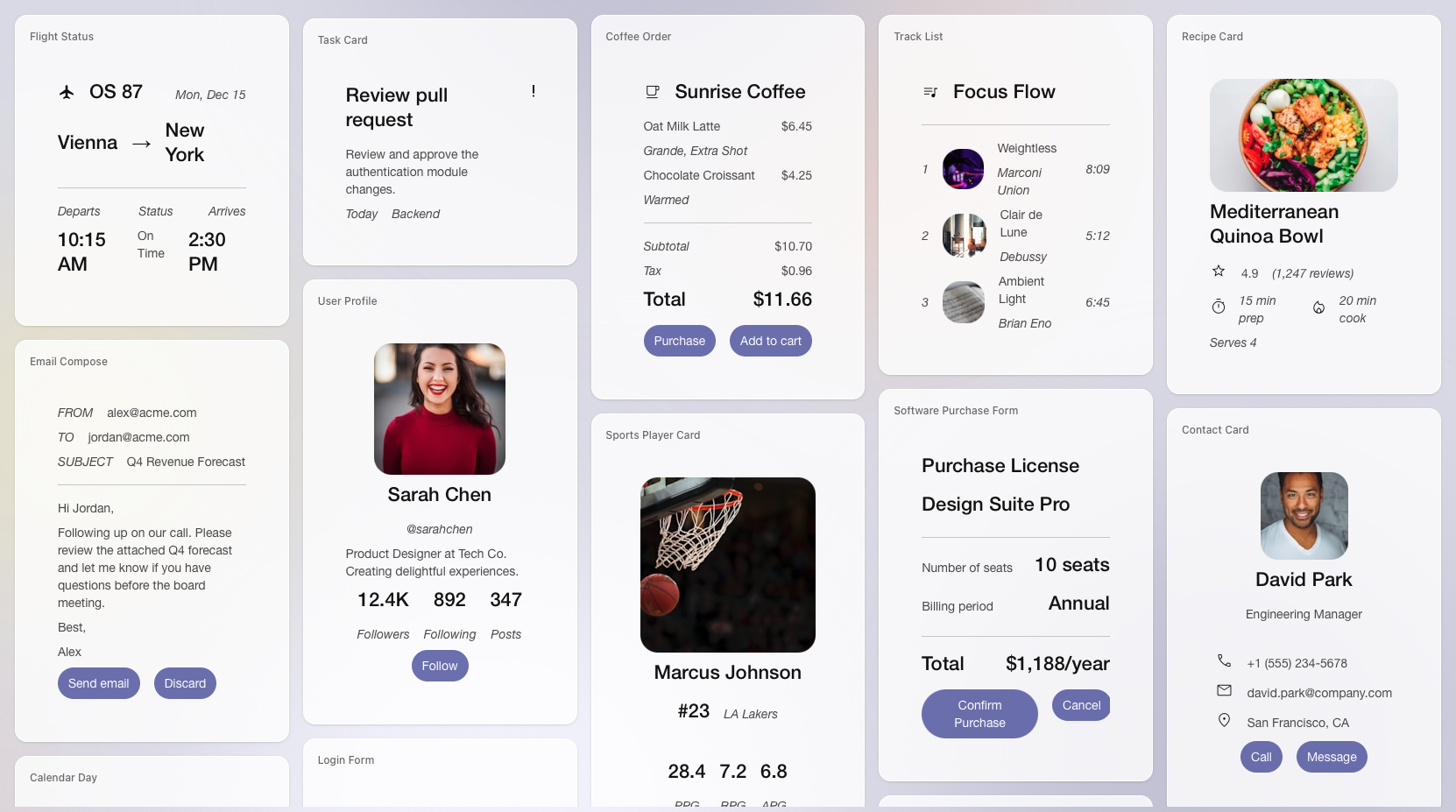

Das A2UI-Projekt von Google markiert einen bedeutenden Wandel in der Art und Weise, wie KI-Agenten mit Benutzern interagieren können – weg von statischen Textantworten hin zu dynamischen, reichhaltigen interaktiven Benutzeroberflächen, die Agenten spontan generieren können. Google A2UI – kurz für Agent-to-User Interface – wurde im Dezember 2025 als Open-Source-Projekt veröffentlicht und etabliert ein Protokoll, mit dem KI-Systeme sicher Schnittstellen beschreiben können, die Anwendungen mit nativen UI-Komponenten rendern. Diese Änderung verspricht eine Vereinheitlichung von KI und Frontend-Engineering auf eine Weise, die sicher, plattformübergreifend und anpassungsfähig für Web- und Mobile-Frameworks ist.

In diesem Artikel erklären wir, was Google A2UI ist, warum es wichtig ist, wie das Google A2UI-Protokoll funktioniert, und zeigen Beispiele aus der Praxis sowie praktische Schritte für den Einstieg – einschließlich Verweisen auf GitHub-Repositorys, Demos und aktuelle Integrationsoptionen wie Flutter.

Bildnachweis: Google

Was ist Google A2UI?

Im Kern ist Google A2UI:

- Ein deklaratives Protokoll (eine Spezifikation) für KI-Agenten zur Kommunikation von Benutzeroberflächenstrukturen an Host-Anwendungen.

- Framework-unabhängig: Dieselben A2UI-Nachrichten können mit React, Angular, Flutter oder praktisch jeder nativen UI-Bibliothek interpretiert und gerendert werden.

- Sicher durch Design: Da A2UI eine JSON-basierte Beschreibung anstelle von ausführbarem Code verwendet, wird das Risiko der Ausführung beliebiger Skripte von Drittanbietern in Ihrer Schnittstelle ausgeschlossen.

- Inkrementell und interaktiv: Der Agent muss nicht die gesamte Benutzeroberfläche auf einmal generieren – er kann Aktualisierungen streamen und die Schnittstelle während der Interaktion des Benutzers verfeinern.

Dieser Ansatz löst ein grundlegendes Problem in verteilten Multi-Agenten-Systemen: Wie kann ein Remote-Agent zu Ihrer Benutzeroberfläche beitragen, ohne Ihre Anwendung Sicherheitslücken oder stilistischen Inkonsistenzen auszusetzen?

Warum Google A2UI für die moderne App-Entwicklung wichtig ist

Historisch gesehen waren Interaktionen zwischen KI-Agenten (wie großen Sprachmodellen) und Benutzern textzentriert. Selbst in Verbindung mit Benutzeroberflächen generieren die Modelle in der Regel einfachen Text oder, in begrenzten Fällen, unstrukturierten HTML-Code. Dieser Ansatz führt aus mehreren Gründen zu Reibungsverlusten in der modernen App-Entwicklung:

- Ineffiziente Arbeitsabläufe: Wenn ein Benutzer strukturierte Aufgaben ausführen möchte (z. B. Tickets buchen oder Formulare ausfüllen), erfordert ein reiner Textdialog wiederholte Hin- und Her-Schritte anstelle intuitiver GUIs.

- Sicherheitsrisiken: Die Generierung von ausführbarem Code oder rohem HTML durch einen KI-Agenten birgt Sicherheitsrisiken – darunter Injektionsangriffe, inkonsistentes Styling und komplexe Integration.

- Fragmentierte UI-Erfahrungen: Eine UI, die von einem externen Agenten als Iframe gerendert wird, sieht oft anders aus und fühlt sich anders an als das Designsystem der übergeordneten Anwendung.

Google A2UI geht diese Herausforderungen direkt an, indem es KI-Agenten ermöglicht, eine Benutzeroberfläche in einem strukturierten Format zu beschreiben, das Host-Apps nativ rendern können. Diese Trennung zwischen der Absicht der Benutzeroberfläche (generiert durch den Agenten) und der Ausführung der Benutzeroberfläche (Host-Rendering) bietet eine sichere, skalierbare und frameworkunabhängige Grundlage für Benutzererfahrungen der nächsten Generation.

So funktioniert das Google A2UI-Protokoll

Das Google A2UI-Protokoll definiert ein strukturiertes, deklaratives JSON-Format, das UI-Komponenten, deren Layout und zugehörige Daten kapselt. Die Host-Anwendung übernimmt dieses Format und rendert es mit ihrem nativen UI-Toolkit.

In der Praxis läuft der Ablauf in der Regel wie folgt ab:

- Benutzerinteraktion: Der Benutzer sendet eine Anfrage an den KI-Agenten (z. B. „Zeige mir verfügbare Flugoptionen“).

- Antwort des Agenten: Der Agent generiert eine A2UI-Nachricht, bei der es sich um eine JSON-Beschreibung von UI-Elementen wie Karten, Schaltflächen, Datumsauswahlfeldern, Diagrammen usw. handelt.

- Übertragung an den Client: Die JSON-Nutzlast wird über einen sicheren Transport (z. B. WebSocket oder A2A-Transport) an die Client-Anwendung gesendet.

- Native Darstellung: Die Client-Anwendung ordnet jede Komponentenbeschreibung einem nativen Widget zu – React im Web oder Flutter auf Mobilgeräten – und erzeugt so eine nahtlose Schnittstelle.

- Benutzerinteraktion: Wenn der Benutzer mit der Schnittstelle interagiert (z. B. auf eine Schaltfläche klickt), wird das Ereignis an den Agenten zurückgesendet, der weitere Aktualisierungen der Benutzeroberfläche generieren kann.

Diese Trennung gewährleistet, dass die Benutzeroberfläche sicher bleibt, vollständig unter der Kontrolle der Host-Anwendung steht und mit dem Designsystem der App übereinstimmt.

Ein KI-Agent analysiert das hochgeladene Foto mit Gemini und generiert dann dynamisch ein maßgeschneidertes Formular für Landschaftsgestaltungsanfragen auf der Grundlage dessen, was er sieht.

Aus einem einfachen Foto-Upload erstellt ein Gemini-gestützter Agent automatisch ein individuelles Formular, das perfekt auf die spezifischen Landschaftsbau-Anforderungen des Kunden zugeschnitten ist.

Wichtige Funktionen und Grundsätze von Google A2UI

Sicherheit an erster Stelle

Eines der größten Probleme bei agentenbasierten Schnittstellen ist die Sicherheit. Im Gegensatz zu HTML/JavaScript-Injektionen, die Ihre Anwendung für Cross-Site-Scripting und andere Schwachstellen anfällig machen können, codiert A2UI Schnittstellenstrukturen in einem deklarativen JSON-Format. Die Client-Anwendung entscheidet, wie diese Beschreibungen in native Widgets abgebildet werden.

LLM-freundlich

Da die A2UI-Spezifikation eine flache Liste von Komponenten mit eindeutigen ID-Referenzen und Statusbindungen verwendet, können große Sprachmodelle Schnittstellenbeschreibungen schrittweise und mit weniger Fehlern generieren. Dies erleichtert es Agenten, kontextbezogene Benutzeroberflächen in Echtzeit zu erstellen.

Rahmenunabhängig

A2UI ist es egal, welches UI-Framework Sie verwenden. Eine einzige JSON-Beschreibung kann gerendert werden auf:

- Webanwendungen (React, Angular, Web Components)

- Mobile Anwendungen (Flutter)

- Desktop-Anwendungen (native Toolkits)

Der Renderer der Host-Anwendung interpretiert die abstrakte UI-Struktur und passt sie an seine nativen Elemente an.

Progressives Rendering

Im Gegensatz zu statischen Schnittstellen, die erst nach vollständigem Laden angezeigt werden, unterstützt A2UI das progressive Rendering. Das bedeutet, dass die Benutzeroberfläche angezeigt, aktualisiert und weiterentwickelt werden kann, während der Agent die Ausgabe generiert – ideal für dialogorientierte, kontextgesteuerte Arbeitsabläufe.

Google A2UI-Beispiel: Benutzeroberfläche für Restaurantreservierungen

Um zu veranschaulichen, wie A2UI in der Praxis funktioniert, hier ein vereinfachtes Beispiel: Anstelle eines reinen Textdialogs, in dem ein Agent nach Datum, Uhrzeit und Anzahl der Gäste fragt, kann der Agent ein strukturiertes UI-Formular generieren:

{

“surfaceUpdate”: {

“surfaceId”: “booking”,

“components”: [

{“id”: “title”, “component”: {“Text”: {“text”: {“literalString”: “Book Your Table”}}}},

{“id”: “datetime”, “component”: {“DateTimeInput”: {“value”: {“path”: “/booking/date”}}}},

{“id”: “submit-btn”, “component”: {“Button”: {“child”: “Confirm”, “action”: {“name”: “confirm_booking”}}}}

]

}

}

Dieses JSON beschreibt Komponenten wie Text, Datums-/Zeitauswahlfelder und Schaltflächen. Wenn die Host-Anwendung es empfängt, rendert sie native Widgets wie einen Kalenderauswahl oder eine „Bestätigen“-Schaltfläche.

Dieses Beispiel zeigt, wie A2UI die Benutzerinteraktion von Text hin und her zu intuitiven grafischen Oberflächen verlagert – entscheidend für komplexe Aufgaben wie Reservierungen oder formularbasierte Workflows.

Wo finden Sie A2UI-Ressourcen und Demos?

Da Google A2UI Open Source ist und sich noch in einer frühen Phase der öffentlichen Vorschau befindet, können Entwickler verschiedene Ressourcen nutzen, um loszulegen:

- A2UI GitHub-Repository: Der offizielle Quellcode und Beispiele für das Protokoll und die ersten Renderer werden auf GitHub gehostet, wo Sie Beispiel-Agenten, Client-Renderer und Demos finden.

- A2UI-Demo (Restaurant Finder): Eine funktionierende Demo zeigt eine vollständig agentenbasierte Benutzeroberfläche, mit der Benutzer über strukturierte Schnittstellen Restaurants in ihrer Nähe finden können.

- A2UI Composer: Mit Community-Tools wie visuellen „Composern” können Entwickler Komponentenbäume visuell erstellen und testen, bevor sie diese bereitstellen.

Für Flutter-Entwickler verwenden Integrationen wie das GenUI SDK für Flutter A2UI als zugrunde liegendes Protokoll für die dynamische UI-Generierung und ermöglichen so plattformübergreifende Erlebnisse, ohne dass die Kernlogik neu geschrieben werden muss.

Google A2UI Composer und Flutter-Integration

Entwickler, die mit Flutter vertraut sind, werden es zu schätzen wissen, wie A2UI komplexe Schnittstellenlogik abstrahiert:

- Flutter-Unterstützung: Die JSON-Beschreibungen von A2UI lassen sich über Renderer sauber auf Flutter-Widgets abbilden, wodurch dynamische Bildschirme erstellt werden können, die in Echtzeit auf Entscheidungen des Agenten reagieren.

- A2UI Composer: CopilotKit und Community-Tools bieten visuelle Builder, mit denen Entwickler Komponenten per Drag & Drop verschieben, eine Vorschau der A2UI-JSON anzeigen und diese zur Verwendung in Agenten oder Host-Anwendungen exportieren können.

Diese Tools helfen dabei, die Lücke zwischen Design und Implementierung zu schließen – indem sie die KI die Benutzeroberfläche steuern lassen, während die Host-App für Konsistenz und Benutzererfahrung sorgt.

Anwendungsfälle aus der Praxis für A2UI

Konversationshandel

Agenten können Produktkataloge, Größenauswahlmenüs und Warenkorb-Oberflächen präsentieren, ohne den Chat verlassen zu müssen. Mit A2UI können Agenten Karussells, Schaltflächen und Formulare nativ rendern, sodass keine separaten Browsing-Bildschirme mehr erforderlich sind.

Interaktive Dashboards

Unternehmensanwendungen benötigen häufig Dashboards mit interaktiven Diagrammen, Tabellen und Steuerelementen. Mit A2UI kann ein KI-Agent eine Dashboard-Oberfläche dynamisch auf Basis von Benutzeranweisungen generieren und aktualisieren, beispielsweise „Verkaufstrends für das 4. Quartal anzeigen“.

Datenvisualisierungstools

Datenanalysten können Agenten bitten, SQL-Abfrageergebnisse zu visualisieren, und A2UI ermöglicht eine native Diagrammdarstellung, die sich in Echtzeit aktualisiert, wenn sich die Abfragen weiterentwickeln – eine weitaus intuitivere Erfahrung als das Parsen von reinen Text-Ergebnissen.

Komplexe Workflow-Benutzeroberflächen

Aufgaben, die normalerweise mehrstufige Benutzeroberflächen erfordern – wie Onboarding, Genehmigungsworkflows oder Konfigurationsfelder – können von Agenten mit einer einzigen Eingabeaufforderung generiert werden. Dies reduziert den Entwicklungsaufwand und beschleunigt die Amortisationszeit.

Herausforderungen und der zukünftige Weg für Google A2UI

Obwohl A2UI leistungsstark ist, befindet es sich noch in einem frühen Stadium (derzeit Version v0.8 Public Preview) und es gibt praktische Überlegungen:

- Unterstützung des Ökosystems: Während erste Renderer für Web und Flutter bereits existieren, ist eine breitere Unterstützung für Frameworks wie React, SwiftUI und Jetpack Compose geplant, aber noch nicht vollständig ausgereift.

- Konsistenz im Design: Entwickler müssen einen Katalog vertrauenswürdiger Komponenten definieren; Agenten können nur Komponenten aus diesem Katalog verwenden, was im Vorfeld ein durchdachtes Designsystem erfordert.

- Entwickler-Know-how: Die effektive Erstellung und Wartung von A2UI-gesteuerten Systemen profitiert von der Vertrautheit sowohl mit generativen Modellen als auch mit Frontend-Designpraktiken.

Trotz dieser Herausforderungen stellt Google A2UI einen entscheidenden Schritt in Richtung agentenbasierter Benutzererfahrungen dar, bei denen Schnittstellen nicht fest programmiert, sondern flexibel als Teil der Interaktion selbst zusammengestellt werden. Beiträge aus der Community und praktische Experimente werden entscheidend dazu beitragen, das Protokoll zu verfeinern und seine praktische Anwendung auszuweiten.

Fazit: Die Rolle von A2UI in der Zukunft der interaktiven KI

Google A2UI positioniert sich als grundlegende Brücke zwischen KI-Agenten und modernen Anwendungs-Frontends. Durch die Abstraktion der Schnittstellengenerierung in ein sicheres, deklaratives Protokoll ermöglicht es KI-Agenten, die Benutzeroberfläche auf eine Weise zu bedienen, die sicher, nativ und frameworkunabhängig ist. Ob komplexe Workflows, interaktive Commerce-Erlebnisse oder dynamische Dashboards – A2UI hat das Potenzial, die Interaktion von Agenten mit Benutzern und Anwendungen gleichermaßen zu verbessern.

Da sich das Ökosystem weiterentwickelt und die Beiträge der Community die verfügbaren Renderer und Beispiele erweitern, könnte A2UI zu einem Standardbestandteil jeder agentenbasierten Plattform werden – und damit eine Ära einläuten, in der Schnittstellen generiert und nicht fest codiert werden.

FAQs

Was ist Google A2UI?

Google A2UI ist ein offenes, deklaratives Protokoll, mit dem KI-Agenten strukturierte UI-Beschreibungen generieren können, die von Host-Anwendungen nativ gerendert werden – ohne dass beliebiger Code ausgeführt werden muss.

Wie gewährleistet das Google A2UI-Protokoll Sicherheit?

Es verwendet ein JSON-basiertes Format anstelle von ausführbarem Code, und die UI-Anfragen des Agenten sind auf einen vertrauenswürdigen Katalog von Komponenten beschränkt, die vom Client definiert werden.

Was ist ein Beispiel für A2UI?

Ein typisches Beispiel ist eine Benutzeroberfläche für Restaurantreservierungen, bei der ein Agent ein Formular mit Datums-/Zeit-Widgets und Aktionsschaltflächen generiert, die als A2UI JSON codiert sind und von der Client-App nativ gerendert werden.

Wo finde ich A2UI-GitHub-Ressourcen?

Das offizielle Repository wird von Google auf GitHub gehostet und enthält Beispielagenten, Renderer und Demos, die Sie sofort ausprobieren können.

Gibt es eine A2UI-Demo?

Ja – zu den unterstützten Demos gehören die Beispiele „Restaurant Finder“ und „Landschaftsarchitekt“, die zeigen, wie ein Agent vollständige Benutzeroberflächen aus dem Kontext erstellen kann.

Kann ich A2UI mit Flutter verwenden?

Ja – das GenUI SDK für Flutter unterstützt A2UI als UI-Deklarationsschicht, sodass Agenten Schnittstellen generieren können, die von Flutter-Anwendungen nativ gerendert werden.