Maschinelles Lernen wandert aus dem experimentellen Bereich in die alltägliche Unternehmenssoftware. Bis 2026 wird sich maschinelles Lernen voraussichtlich neu gestalten und stärker in Entscheidungsprozesse eingebunden sein. Unternehmen verlassen sich heute nicht nur bei Zukunftsprognosen, sondern auch bei operativen Entscheidungen in Echtzeit, die sich entscheidend auf Umsatz, Kundenerfahrung und Wachstum auswirken können, zunehmend auf Modelle. Aufgrund dieser Veränderung ist es für Unternehmen unerlässlich geworden, die unterschiedlichen Verhaltensweisen von Algorithmen für maschinelles Lernen und deren jeweilige Stärken zu verstehen.

In diesem Leitfaden erklären wir Ihnen die wichtigsten Begriffe, die in der Branche verwendet werden, und stellen sie Ihnen präzise, klar und aus praktischer Sicht vor.

Was ist ein Algorithmus für maschinelles Lernen?

Ein Algorithmus für maschinelles Lernen bezeichnet im Wesentlichen eine bestimmte Methode, mit der Daten untersucht, Muster überprüft und zur Klassifizierung oder Vorhersage neuer Informationen verwendet werden. Ein einfaches Beispiel für einen solchen Algorithmus ist ein Hauspreisvorhersager, der vergangene Verkäufe analysiert. Diese Algorithmen sind von großer Bedeutung, da sie strategisch festlegen, wie schnell und genau ein Modell in einem realen Arbeitsablauf Bewertungen vornimmt, lernt und Entscheidungen unterstützt.

Wie Algorithmen für maschinelles Lernen funktionieren

Mehrere ML-Algorithmen haben einen gemeinsamen Prozess, obwohl jeder einzelne die Daten unterschiedlich verwaltet. In diesem Prozess beginnen Sie mit den Rohdaten, bereinigen diese und wandeln sie schließlich in eine nutzbare Funktion um. Unmittelbar nach diesem Prozess wird das Modell anhand eines Teils der Daten trainiert und anhand des restlichen Teils getestet. Wenn die Leistung gut ist, wird das Modell in die Produktion übernommen.

Ein grundlegender Arbeitsablauf lässt sich wie folgt visualisieren:

Daten → Merkmalsauswahl → Algorithmusauswahl → Training → Testen → Bewertung

Durch Training lernt das System, wie verschiedene Merkmale mit Labels zusammenhängen. Durch Tests wird überprüft, ob diese Zusammenhänge auch bei neuen Beispielen zutreffen. Saubere Daten, korrekte Metriken und die richtige Methode beeinflussen die endgültige Zuverlässigkeit jeder Machine-Learning-Lösung.

Top 10 Algorithmen für maschinelles Lernen

Bevor wir uns mit den detaillierten Erläuterungen befassen, finden Sie hier die zehn Algorithmen, die in diesem Leitfaden behandelt werden, zusammen mit ihren entscheidenden Vorteilen:

- Lineare Regression – Schnelle Prognosen und Modellierung von Beziehungen.

- Logistische Regression – Beste Algorithmen für binäre und mehrklassige Klassifizierung.

- Entscheidungsbäume – Leicht zu visualisieren und einfach zu interpretieren.

- Random Forest – Bietet eine höhere Genauigkeit und eignet sich daher am besten für unübersichtliche Datenbanken.

- Support Vector Machines (SVM) – Effektiv bei hochdimensionalen Problemen.

- K-Means-Clustering – Starke unüberwachte Leistung und einfache Gruppierung.

- K-Nearest Neighbours (KNN) – Nützlich für ähnlichkeitsbasierte Vorhersagen.

- Naïve Bayes – Schnell und genau für textorientierte Aufgaben.

- Gradient Boosting Machines (GBM) – Wettbewerbsfähige Genauigkeit.

- Neuronale Netze – Rückgrat moderner Deep-Learning-Algorithmen.

Im Folgenden finden Sie eine detaillierte Beschreibung jeder Methode, wo sie eingesetzt wird und wie Teams im Jahr 2026 sie nutzen.

1. Lineare Regression

Die lineare Regression ist nach wie vor ein praktischer Ausgangspunkt für Prognoseprobleme. Sie bildet die Beziehung zwischen Variablen in einer geraden Linie ab, wodurch sie unglaublich einfach zu interpretieren ist. Analysten verwenden sie nach wie vor für Umsatzprognosen, Marketingbudgets und Trendanalysen in der Frühphase. Selbst wenn Teams den Übergang zu fortgeschrittenen Modellen planen, dient die lineare Regression oft als Grundlage für den Vergleich zukünftiger Verbesserungen.

2. Logistische Regression

Die logistische Regression befasst sich speziell mit Klassifizierungsproblemen und sagt voraus, was zu einer bestimmten Gruppe gehört. Die wahrscheinlichkeitsbasierten Ergebnisse helfen Unternehmen, die Wahrscheinlichkeit von Ergebnissen zu verstehen, was letztendlich in Bereichen wie Kundenabwanderung, Kreditgenehmigung und einfachen Entscheidungsfindungen von Vorteil ist. Unternehmen bevorzugen sie auch 2026 noch aufgrund ihrer Transparenz und einfachen Parametereinstellung.

3. Entscheidungsbäume

Entscheidungsbäume stellen Daten in einer verzweigten Struktur dar und zerlegen komplexe Entscheidungen in schrittweise Pfade. Dadurch lassen sie sich Unternehmensleitern sehr leicht erklären. Die Methode eignet sich sowohl für numerische als auch für kategoriale Variablen und kann fehlende Werte ohne aufwendige Vorverarbeitung verarbeiten. Branchen wie das Gesundheitswesen und das Bankwesen verlassen sich nach wie vor auf Entscheidungsbäume, wenn die Interpretierbarkeit des Modells unverzichtbar ist.

4. Random Forest

Random Forest erstellt viele Entscheidungsbäume und führt deren Vorhersagen zu einem Ergebnis zusammen. Dieser Ansatz hilft, Überanpassung zu reduzieren, was ein häufiges Problem bei einzelnen Bäumen ist. Aufgrund seiner Stabilität und zuverlässigen Genauigkeit wird es heute häufig in der Betrugserkennung, der Kreditvergabe, der Versicherungsmodellierung und in Produktempfehlungssystemen eingesetzt. Es verarbeitet verrauschte Eingaben viel besser als die meisten traditionellen Algorithmen des maschinellen Lernens.

5. Support Vector Machines (SVM)

Support Vector Machines suchen nach der besten Grenze, die Klassen voneinander trennt. SVMs erzielen außergewöhnlich gute Ergebnisse, wenn die Daten viele Merkmale aufweisen, weshalb sie in Bereichen wie Genetik, Textklassifizierung und sogar einigen Aufgaben der Bildverarbeitung nach wie vor eine große Bedeutung haben. Mit Kernel-Optionen passen sich SVMs an nichtlineare Muster an, was ihnen einen Vorteil gegenüber einfacheren linearen Modellen verschafft.

6. K-Means-Clustering

K-Means ist einer der gängigsten unüberwachten ML-Algorithmen. Er gruppiert Datenpunkte anhand ihrer Ähnlichkeit, in der Regel durch Minimierung des Abstands zwischen den Punkten und dem Clusterzentrum. Unternehmen nutzen ihn für die Zielgruppensegmentierung, Kundenprofilierung, Geschäftszonierung, Bestands kategorisierung und operative Gruppierung. Er ist nach wie vor sehr beliebt, da er einfach zu implementieren ist und sich gut auf große Datensätze skalieren lässt.

7. K-Nearest Neighbours (KNN)

KNN trifft Vorhersagen auf der Grundlage der Nähe neuer Datenpunkte zu bestehenden Beispielen. Es funktioniert am besten in Szenarien, in denen ähnliche Elemente im Merkmalsraum nahe beieinander liegen. E-Commerce-Unternehmen nutzen KNN für Empfehlungen, während medizinische Zentren es zur Klassifizierung von Patientensymptomen einsetzen. Es erfordert kein explizites Training, was bedeutet, dass Teams schnell funktionsfähige Modelle erstellen können, wenn der Einsatzbedarf dringend ist.

8. Naïve Bayes

Naïve Bayes basiert speziell auf Annahmen und Wahrscheinlichkeiten sowie der Analyse, dass Merkmale unabhängig voneinander agieren. Trotz dieser Vereinfachungen funktioniert es strategisch gut, insbesondere bei der Spam-Erkennung, der Sentiment-Analyse und der Klassifizierung kurzer Texte. Startups verlassen sich häufig auf Naïve Bayes für leichtgewichtige Anwendungen, bei denen Ressourcen wie Chat-Triage, intelligente Filter und schnelle Inhaltskennzeichnung begrenzt sind.

9. Gradient Boosting Machines (GBM)

GBM und seine beliebten Varianten wie XGBoost, CatBoost und LightGBM bilden heute eine der genauesten Kategorien von Algorithmen für maschinelles Lernen. Diese Methoden trainieren mehrere schwache Lerner nacheinander und verbessern dabei die Fehlerquote bei jedem Schritt. Teams für Finanzmodellierung, Betrugsanalyse und Bonitätsbewertung sind stark auf GBM angewiesen, da es nichtlineare Trends mit beeindruckender Präzision erfasst. Trotz seiner längeren Trainingszeit führt GBM weiterhin die Leistungsbenchmarks für strukturierte Daten an.

10. Neuronale Netze

Neuronale Netze bilden die Grundlage für mehrere Deep-Learning-Algorithmen, darunter CNNs, RNNs, LSTMs und Transformer-basierte Architekturen. Diese Modelle eignen sich hervorragend für Aufgaben wie Sprachinterpretation, autonome Fahrsignale, medizinische Bildgebung und das Verstehen natürlicher Sprache. Obwohl sie mehr Rechenleistung erfordern, sind neuronale Netze in Bezug auf Genauigkeit unübertroffen, wenn Datensätze groß und Muster komplex sind. Im Jahr 2026 integriert fast jede moderne KI-Plattform irgendwo in ihrer Pipeline neuronale Komponenten.

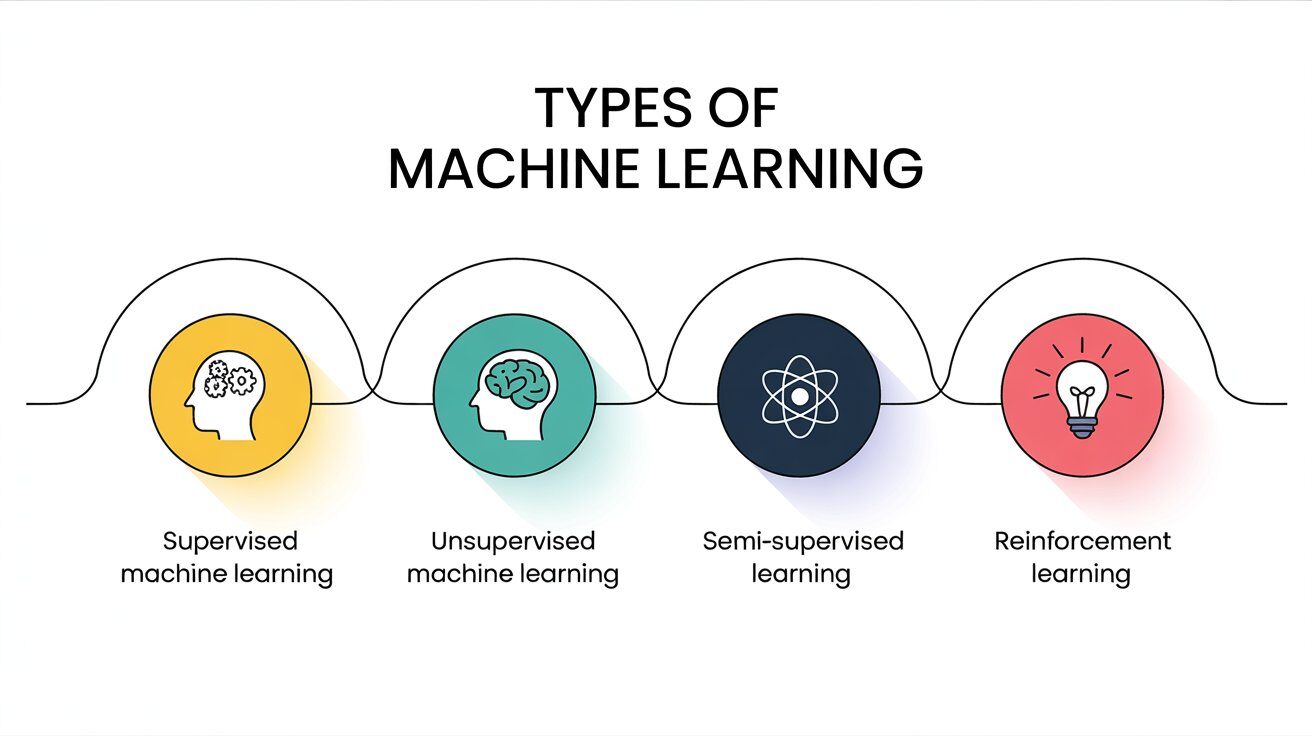

Arten von Algorithmen für maschinelles Lernen

Die meisten Methoden lassen sich einer der folgenden Kategorien zuordnen:

- Überwachtes Lernen – Verwendet gekennzeichnete Daten (z. B. lineare Regression, Random Forest).

- Unüberwachtes Lernen – Arbeitet mit nicht gekennzeichneten Daten (z. B. K-Means).

- Halbüberwachtes Lernen – Mischt gekennzeichnete und nicht gekennzeichnete Eingaben.

- Verstärkendes Lernen – Systeme lernen, indem sie Aktionen ausführen und Belohnungen erhalten.

Die Kenntnis des Typs hilft dabei, den richtigen Ansatz einzugrenzen, bevor ein vollständiges System aufgebaut wird.

Auswahl des richtigen Algorithmus

Die Auswahl der richtigen Methode ist nicht immer einfach. Hier sind einige Entscheidungsfaktoren, die von Teams häufig herangezogen werden:

- Datensatzgröße

- Art des Problems (Klassifizierung, Regression, Clustering)

- Notwendigkeit der Interpretierbarkeit

- Erforderliche Genauigkeit

- Trainingszeit

- Betriebliche Einschränkungen

- Echtzeitanforderungen

Vergleichstabelle

| Algorithmus | Genauigkeit | Trainingszeit | Interpretierbarkeit | Primäre Stärke |

| Linear Regression | Mittel | Schnell | Hoch | Prognose |

| Logistic Regression | Mittel | Schnell | Hoch | Einfache Klassifizierung |

| Decision Tree | Mittel | Mittel | Hoch | Regelbasierte Entscheidungen |

| Random Forest | Hoch | Mittel | Mittel | Komplexe Vorhersagen |

| SVM | Hoch | Langsam | Mittel | Hochdimensionale Daten |

| K-Means | Mittel | Schnell | Mittel | Mustergruppierung |

| KNN | Mittel | Langsam (Inferenz) | Niedrig | Ähnlichkeitsprüfungen |

| Naïve Bayes | Mittel | Schnell | Mittel | Textklassifizierung |

| GBM | Sehr hoch | Langsam | Niedrig | Strukturierte Datensätze |

| Neural Networks | Sehr hoch | Langsam | Niedrig | Deep-Learning-Aufgaben |

Beispiele für die Wahl eines Algorithmus gegenüber einem anderen

- Bei kleinen Datensätzen mit einer klaren Entscheidungsgrenze funktioniert die logistische Regression oft besser als komplexe Systeme.

- Wenn die Zusammenhänge kompliziert sind, sind Random Forest oder GBM in der Regel die sicherere Wahl.

- Bei der Textklassifizierung schneidet Naïve Bayes mit weitaus geringerem Rechenaufwand tendenziell besser ab als andere Verfahren.

- Bei visuellen oder sprachlichen Problemen sind neuronale Netze in der Regel die erste Wahl.

Beispiele aus der Praxis

Betrugserkennung

Banken kombinieren häufig Random Forest und GBM, um ungewöhnliches Ausgabeverhalten zu erkennen. Diese Methoden erfassen subtile Veränderungen bei Transaktionen besser als herkömmliche lineare Modelle.

Empfehlungssysteme

Plattformen wie Streaming-Dienste oder E-Commerce-Shops kombinieren neuronale Netze und KNN, um relevante Artikel vorzuschlagen. Die auf Ähnlichkeit basierende Natur von KNN hilft dabei, Empfehlungen zu verfeinern.

Bildklassifizierung

Neuronale Netze dominieren bei groß angelegten Bilderkennungsaufgaben, obwohl SVM bei kleineren Datensätzen immer noch überlegen ist.

Vorhersage der Kundenabwanderung

Logistische Regression, GBM und Random Forest werden häufig eingesetzt, um Signale zu identifizieren, die darauf hindeuten, dass ein Kunde kurz davor steht, abzuwandern.

Leistungsvergleich

| Algorithmus | Genauigkeit | Speichernutzung | Echtzeitnutzung | Ideale Anwendung |

| Linear Regression | Mäßig | Niedrig | Ja | Trendprognose |

| Logistic Regression | Mäßig | Niedrig | Ja | Binäre Entscheidungen |

| Decision Tree | Mäßig | Niedrig | Ja | Transparente Entscheidungen |

| Random Forest | Hoch | Mittel | Begrenzt | Aufgaben mit mehreren Variablen |

| SVM | Hoch | Mittel | Begrenzt | Hochdimensionale Daten |

| K-Means | Mittel | Niedrig | Ja | Clusterbildung |

| KNN | Mittel | Hoch | Nein | Ähnlichkeitsvorhersagen |

| Naïve Bayes | Mittel | Niedrig | Ja | Text-Aufgaben |

| GBM | Sehr hoch | Hoch | Nein | Datenwettbewerbe |

| Neural Networks | Sehr hoch | Hoch | Begrenzt | Deep-Learning-Algorithmen |

Häufige Fehler, die Anfänger machen

- Überanpassung durch zu langes Training oder schlechte Abstimmung.

- Falsche Bewertungsmetriken, insbesondere bei Verwendung der Genauigkeit in unausgewogenen Datensätzen.

- Überspringen der Vorverarbeitung, was sich auf fast jeden Algorithmus negativ auswirkt.

- Verwendung übermäßig komplexer Modelle, obwohl einfachere Modelle genauso gut funktionieren würden.

- Ignorieren der Interpretierbarkeit, insbesondere in Bereichen, die transparente Entscheidungsregeln erfordern.

Schlussfolgerung

Die Auswahl der richtigen Algorithmen für maschinelles Lernen ist mittlerweile zu einer wichtigen Entscheidung geworden, da der Kern des Geschäfts in der Praxis von genauen Vorhersagen abhängt. Während neuronale Systeme bei Bildern, Sprache und anderen kritischen Eingaben führend sind, dominieren traditionelle Algorithmen für maschinelles Lernen nach wie vor die Bereiche Gesundheitswesen, Finanzen und Geschäftsanalytik, einfach weil sie Klarheit und Zuverlässigkeit bieten. Das Hauptmotiv besteht darin, den Algorithmus an die Komplexität Ihres Problems, die Größe Ihrer Daten und den Grad der Interpretierbarkeit, den Sie benötigen, anzupassen. Mit Hilfe der richtigen Balance werden diese 10 Methoden auch weiterhin die effektivste Anwendbarkeit des maschinellen Lernens ermöglichen, insbesondere im Jahr 2026.

FAQs

Welcher ML-Algorithmus eignet sich am besten für Anfänger?

Lineare Regression und logistische Regression sind am einfachsten für den Einstieg, da sie unkompliziert und zuverlässig sind.

Ist Deep Learning auch ein Algorithmus?

Deep Learning bezeichnet eine Gruppe von Methoden, die hauptsächlich auf neuronalen Netzen basieren.

Welcher ML-Algorithmus ist am einfachsten zu verwenden?

Naïve Bayes ist oft der einfachste, da er schnell trainiert und gut mit Text funktioniert.

Welcher Algorithmus eignet sich am besten für die Klassifizierung?

Random Forest, SVM und GBM erzielen in der Regel eine hohe Genauigkeit bei Klassifizierungsproblemen.

Was ist der Unterschied zwischen überwachtem und unüberwachtem Lernen?

Überwachtes Lernen arbeitet mit gekennzeichneten Daten, während unüberwachtes Lernen nach Mustern ohne vordefinierte Kennzeichnungen sucht.