Die NVIDIA H200 ist eine speziell für generative KI, Hochleistungsrechner und große Sprachmodelle entwickelte High-End-GPU mit Schwerpunkt auf Datenverarbeitung. Sie basiert auf der Hopper-Architektur und gilt als die erste NVIDIA-GPU mit einer Speicherkapazität von 141 GB. Außerdem verfügt sie über HBM3e-Speicher und einen großen Speicher mit 4,8 TB/s. Dieses Gerät ermöglicht schließlich die Anbindung oder das Training groß angelegter KI-Modelle sowie HPC-Workloads.

In diesem Blog werden wir sie mit ihrem Vorgängermodell vergleichen, das letztendlich einen deutlich höheren Durchsatz und eine größere Speicherkapazität bietet. Dies macht sie auch zu einer idealen Wahl für massive Modellbereitstellungen und Inferenz in großem Maßstab.

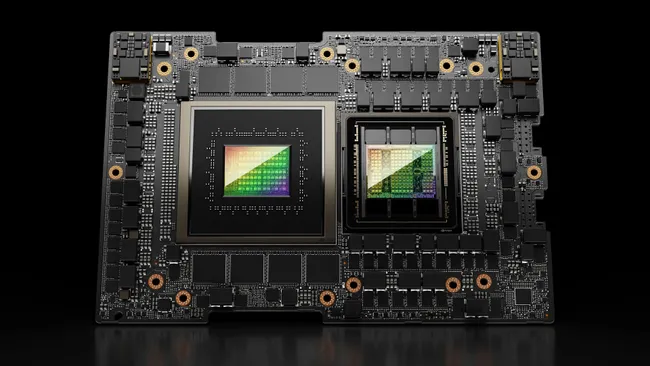

Bildnachweis: Nvidia

Wichtige Spezifikationen (NVIDIA H200-Spezifikationen)

| Spezifikation / Merkmal | H200 SXM / H200 NVL (GPU für Rechenzentren) |

| GPU-Speicher | 141 GB HBM3e |

| Speicherbandbreite | 4.8 TB/s |

| FP8-Tensor-Leistung | Bis zu ~ 4 PetaFLOPS |

| FP16-/BFLOAT16-/FP32-Leistung | Sehr hoch – optimiert für KI-Workloads |

| Formfaktoren | SXM (Server-Klasse) oder NVL/PCIe-Versionen |

| Leistungsaufnahme (TDP) | Bis zu 700 W (SXM) oder bis zu 600 W (NVL/PCIe), je nach Konfiguration |

| Verbindung / Multi-GPU | NVLink (900 GB/s) + PCIe Gen5 (128 GB/s) |

In einigen Datenblättern wird die GPU-Kernanzahl für die SXM/PCIe-SKUs mit 16.896 Shading-Einheiten (allgemein als „Kerne” bezeichnet) angegeben.

Diese Hardware macht den H200 zu einem Kraftpaket für inferenzintensive Aufgaben, den Einsatz von LLM in großem Maßstab und rechenintensive HPC-Anwendungen. In den eigenen Benchmarks von NVIDIA liefert der H200 im Vergleich zu den H100-GPUs der vorherigen Generation eine etwa doppelt so schnelle Inferenz für große Modelle.

Veröffentlichungszeitplan und Markteinführung (Veröffentlichungsdatum H200)

- Laut NVIDIA wurde der H200 ab dem zweiten Quartal 2024 für globale Systemintegratoren und Cloud-Dienstleister verfügbar gemacht.

- Seitdem wird er von großen Cloud-Anbietern und Rechenzentren sowohl für KI-Training/Inferenz als auch für HPC-Workloads eingesetzt.

Preissituation (Was kostet der NVIDIA H200-Chip?)

- Direkte öffentliche Preislisten für H200 werden nicht allgemein veröffentlicht; jedoch lagen die Preise für GPU-Chips der früheren Generation (z. B. H100) laut einigen Marktschätzungen für Rechenzentrumskonfigurationen im Bereich von 25.000 bis 40.000 US-Dollar.

- Angesichts der höheren Leistung und der Positionierung als Produkt für Unternehmen dürfte der H200 einen höheren Preis als seine Vorgänger haben, insbesondere wenn er in Serverkonfigurationen mit mehreren GPUs eingesetzt wird.

- Für die meisten Nutzer wird der H200 in erster Linie über Cloud-GPU-Instanzen oder Vereinbarungen mit Unternehmensrechenzentren erhältlich sein und nicht im direkten Einzelhandel.

Daher ist es schwierig, einen genauen Verkaufspreis zu bestimmen; die H200 ist fest als High-End-KI-GPU der Enterprise-Klasse positioniert.

Aktuelle politische und geopolitische Lage: Export nach China genehmigt

Eine wichtige aktuelle Entwicklung: Seit Dezember 2025 hat die US-Regierung unter Donald Trump den Export des H200-Chips an „zugelassene Kunden” in China genehmigt – und damit frühere Beschränkungen aufgehoben.

Wichtige Details der Entscheidung:

- Exporte, die vom US-Handelsministerium geprüft werden.

- Verkäufe nach China unterliegen einer Gebühr/einem Zollsatz von 25 %, der von der US-Regierung erhoben wird.

- Fortschrittlichere Chips (wie die kommenden GPUs der Blackwell-Generation von NVIDIA) sind weiterhin von der Ausfuhrgenehmigung ausgeschlossen.

Diese Entscheidung öffnet einen wichtigen Markt (China) für H200 wieder, was sich auf das weltweite Angebot, die Preisgestaltung und die Einsatzstrategien auswirken könnte – insbesondere für Cloud-Anbieter und Unternehmen, die regionenübergreifend tätig sind.

Warum H200 wichtig ist: Anwendungsfälle und Bedeutung

Groß angelegte KI-/LLM-Inferenz und -Training

Dank seines 141 GB großen HBM3e-Speichers und seines hohen Durchsatzes eignet sich der H200 hervorragend für die Ausführung großer Sprachmodelle oder generativer KI-Workloads. So kann er beispielsweise massive LLMs verarbeiten, die viel Speicher und Rechenleistung erfordern – ideal für Unternehmen, die an generativer KI, AI-as-a-Service oder hochleistungsfähigen Inferenzsystemen arbeiten.

Hochleistungsrechnen (HPC) und wissenschaftliche Workloads

Über KI hinaus eignet sich H200 aufgrund seiner enormen Speicherbandbreite und Rechenleistung für wissenschaftliche Simulationen, Datenanalysen in großem Maßstab, physikalische Modellierung und andere HPC-Aufgaben, bei denen sowohl der Speicherdurchsatz als auch die parallele Rechenleistung eine Rolle spielen.

Cloud- und Unternehmensbereitstellungen in großem Maßstab

Aufgrund seiner Leistung und Speicherkapazität eignet sich H200 gut für den Einsatz in Multi-GPU-Servern, cloudbasierten KI-Instanzen oder Rechenzentrumsclustern. Große Unternehmen und Cloud-Anbieter profitieren von seinem hohen Durchsatz und Speicher, um hohe Workloads mit weniger GPUs zu unterstützen.

Überlegungen und Kompromisse

- Stromverbrauch und Kühlung: Mit einer TDP von bis zu 700 W für SXM-Varianten erfordern H200-Implementierungen eine robuste Stromversorgungs- und Kühlinfrastruktur, was mit hohen Kosten und Infrastrukturüberlegungen verbunden ist.

- Kosten und Zugang: Angesichts seiner Positionierung für Unternehmen und des voraussichtlich hohen Preises dürfte H200 in erster Linie für Organisationen, Cloud-Dienstleister oder Forschungseinrichtungen zugänglich sein und weniger für einzelne Käufer.

- Auswirkungen geopolitischer/Exportbeschränkungen: Die Verfügbarkeit in bestimmten Regionen (oder der Export nach China) kann, wie die jüngsten Entwicklungen zeigen, staatlichen Vorschriften und Exportkontrollrichtlinien unterliegen. Dies kann sich auf das Angebot, die Preisgestaltung und den Zeitrahmen für die Einführung auswirken.

Was die jüngste Exportgenehmigung für die Branche bedeutet

- Wiederaufnahme des Zugangs für chinesische Cloud-/KI-Unternehmen: Chinesische Unternehmen und Cloud-Anbieter können wieder H200-GPUs erwerben, was die KI- und HPC-Kapazitäten in China potenziell steigern könnte – allerdings unter strenger Aufsicht und mit einer zusätzlichen Ausfuhrgebühr von 25 %.

- Auswirkungen auf den globalen Markt: Die Wiederöffnung Chinas als bedeutender Markt könnte die Gesamtnachfrage nach H200 erhöhen und sich möglicherweise auf das globale Angebot, die Lieferzeiten und die Beschaffungsstrategien von Unternehmen auswirken.

- Strategische Positionierung gegenüber neuen Chips: Während H200 nun für den Export zugelassen ist, unterliegen fortschrittlichere Chips von NVIDIA (z. B. Blackwell) weiterhin Beschränkungen – was bedeutet, dass H200 vorerst zum de facto „globalen Flaggschiff” werden könnte.

Schlussfolgerung

Der NVIDIA H200-Chip gilt als einer der leistungsstärksten HPC-GPUs und AIs, die derzeit erhältlich sind. Diese Chips bieten einen enormen Speicherplatz und eignen sich für groß angelegte Schnittstellen, wissenschaftliche Workloads und Schulungen. Dieses Produkt wurde speziell für den weltweiten Einsatz im Jahr 2024 entwickelt, das aufgrund der sich wandelnden geopolitischen Lage und der Entwicklungen im Bereich der Expertensteuerung zunehmend an Bedeutung gewinnt.

Für Unternehmen, KI-intensive Organisationen und Cloud-Anbieter bietet H200 eine massive Grundlage für generative KI, HPC und große Modulschnittstellen. Bei der Bereitstellung solcher Software müssen jedoch die Stromversorgung und die Lieferkette berücksichtigt werden. Überlegungen zu Guss und Regulierung.

Mit der kürzlich erteilten Genehmigung für Exporte nach China könnte sich die globale Präsenz von H200 weiter ausdehnen und möglicherweise die weltweite Verteilung von High-End-KI-Infrastrukturen neu gestalten.

FAQs

Wann wurde die NVIDIA H200 veröffentlicht?

Die H200 ist seit dem zweiten Quartal 2024 weltweit (über Systemhersteller und Cloud-Anbieter) erhältlich.

Was sind die wichtigsten Spezifikationen (Speicher, Leistung, Kerne) der H200?

Die H200 verfügt über 141 GB HBM3e-Speicher, 4,8 TB/s Bandbreite, bis zu ~4 PetaFLOPS (FP8 Tensor) Rechenleistung und einen Stromverbrauch von bis zu 700 W (SXM) oder 600 W (PCIe/NVL), je nach Variante.

Ist der H200 hauptsächlich für KI/maschinelles Lernen oder auch für HPC/wissenschaftliche Workloads gedacht?

Beides. Der H200 wurde zwar mit Blick auf generative KI und LLM-Inferenz/Training entwickelt, eignet sich aber aufgrund seiner hohen Speicherbandbreite und Rechenleistung auch sehr gut für wissenschaftliche Berechnungen, Simulationen, Datenanalysen und andere HPC-Aufgaben.

Wie viel kostet ein H200-Chip?

Es gibt keinen allgemein veröffentlichten Verkaufspreis. GPUs der vorherigen Generation (z. B. H100) wurden für Datenzentrumskonfigurationen zu Preisen zwischen 25.000 und 40.000 US-Dollar verkauft. Der H200 ist aufgrund seiner höheren Leistung wahrscheinlich ähnlich teuer oder sogar teurer, aber der genaue Preis hängt von der Konfiguration und dem Beschaffungsweg (Cloud vs. vor Ort) ab.

Können Unternehmen in China jetzt H200-GPUs kaufen?

Ja – seit Dezember 2025 erlaubt die US-Regierung den Export von H200-Chips an zugelassene chinesische Kunden unter Aufsicht des US-Handelsministeriums und gegen eine Exportgebühr von 25 %.