Alibabas neueste Ergänzung der Qwen3-Familie, das Modell Qwen3-235B-A22B-Instruct-2507, hat in der Open-Source-KI-Welt für Aufsehen gesorgt. Dieses vollständig zugängliche Modell, das unter der Apache-2.0-Lizenz veröffentlicht wurde, bietet eine enorme Leistungsfähigkeit in den Bereichen Schlussfolgerungen, Sprache und Codierung und festigt Alibabas Status als wichtiger Konkurrent von GPT-4o, Claude Opus 4, DeepSeek-V3 und Kimi K2.

Die Architektur: MoE, Long Context und dedizierter Befehlsmodus

- Mixture-of-Experts (MoE): Das Modell enthält 235 Milliarden Parameter, aber nur 8 von 128 Expertenschichten (≈ 22 Milliarden Parameter) werden pro Inferenz aktiviert – dies sorgt für eine hohe Kapazität bei geringeren Laufzeitkosten.

- Natives 256-K-Kontextfenster: Unterstützt extrem lange Texte in einer einzigen Eingabe – besonders wirkungsvoll für Zusammenfassungen, Dokumentenanalysen und Langform-Interaktionen.

- Nur Nicht-Denkmodus: Im Gegensatz zu früheren Hybridvarianten ist diese Version rein auf Anweisungstexte optimiert; sie gibt keine -Ketten aus. Die Bereitstellung ist einfacher und schneller, da keine Aktivierung des Denkmodus erforderlich ist.

Bild: Qwen

Was ist neu im Update für Instruct-2507?

Alibaba veröffentlichte diese Version am 21. Juli 2025 nach Rückmeldungen aus der Community, wobei der Schwerpunkt auf der Trennung von Argumentation und Anwendungsfällen lag. Die wichtigsten Verbesserungen:

- Verbesserte Befolgung von Anweisungen und interne Abstimmung, insbesondere bei offenen Aufgaben.

- Erweitertes Fachwissen und mehrsprachige Abdeckung von Nischenthemen in 119 Sprachen und Dialekten.

- Leistungssteigerungen in Mathematik, Naturwissenschaften, logischem Denken, Programmierung und Werkzeuggebrauch.

Außerdem wurde eine quantisierte FP8-Version eingeführt, die den Speicherbedarf bei minimalem Leistungsverlust deutlich reduziert – ideal für Umgebungen mit begrenzten Ressourcen.

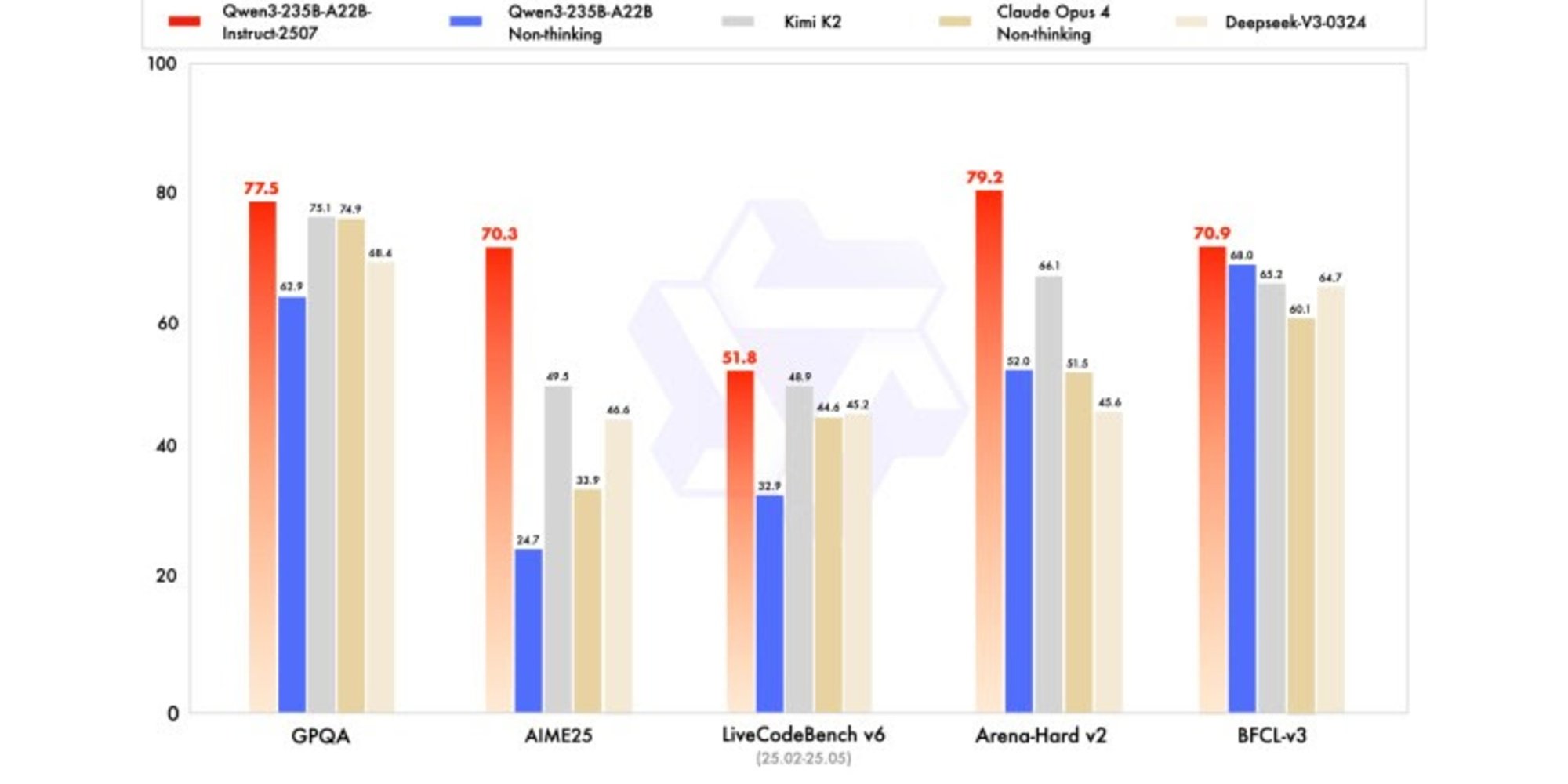

Benchmark-Leistung im Vergleich zu den wichtigsten Wettbewerbern

Qwen3‑235B‑A22B‑Instruct‑2507 liefert hervorragende Ergebnisse und liegt häufig sowohl in öffentlichen Benchmarks als auch in internen Bewertungen an der Spitze:

| Benchmark | Qwen3‑2507 | GPT‑4o‑0327 | Claude Opus 4 | DeepSeek‑V3 | Kimi K2 |

| MMLU‑Pro | 83.0 | 79.8 | 86.6 | 81.2 | 75.2 |

| MMLU‑Redux | 93.1 | 91.3 | 94.2 | 90.4 | 89.2 |

| GPQA (advanced QA) | 77.5 | 66.9 | 74.9 | 68.4 | 62.9 |

| CSimpleQA | 84.3 | 60.2 | 68.0 | 71.1 | 60.8 |

| AIME25 (Math) | 70.3 | 26.7 | 33.9 | 46.6 | 24.7 |

| ZebraLogic (Logic) | 95.0 | 52.6 | — | 83.4 | 89.0 |

| LiveCodeBench v6 | 51.8 | 35.8 | 44.6 | 45.2 | 48.9 |

| MultiPL‑E (Coding) | 87.9 | 82.7 | 88.5 | 82.2 | 79.3 |

| Arena‑Hard v2 (Align) | 79.2 | 61.9 | 51.5 | 45.6 | 66.1 |

| WritingBench | 85.2 | 75.5 | 79.2 | 74.5 | 77.0 |

Qwen3-2507 zeichnet sich insbesondere in den Bereichen Mathematik (AIME), Logik (ZebraLogic) und Programmierung (MultiPL-E) aus und übertrifft dabei häufig proprietäre Modelle oder erreicht deren Leistungsniveau.

Feedback aus der Community: Lob und Vorbehalte

Was Entwickler lieben

- Code-Fähigkeiten: Viele berichten, dass Qwen3-2507 bei Programmieraufgaben mit Premium-Modellen wie Claude Sonnet / Opus mithalten kann.

- Lokale Leistung: Auf moderner Hardware (M-Chips, Unified Memory oder 80 GB RAM + 8 GB GPU) läuft das Modell mit optimierten quantisierten Versionen reibungslos mit >6 Tokens/Sekunde.

- Kosteneffizienz: Es unterstützt Self-Hosting unter Apache 2.0 und ermöglicht so leistungsstarke Inferenz ohne hohe API-Gebühren.

Gemeldete Einschränkungen

- Benchmark vs. reale Lücke: Einige Nutzer bemerken eine leichte Unterperformance bei langfristigen oder kontextuell komplexen Aufgaben im Vergleich zu den Benchmark-Ergebnissen.

- Keine Gedankenkette: Ohne Denkmodus kann Qwen3-2507 bei Aufgaben, die tiefgreifendes mehrstufiges Denken erfordern, ins Stocken geraten, während Denkmodelle wie AM-Thinking-v1 oder Qwen3-Thinking-2507 hier hervorragende Leistungen erbringen.

- Wissensbegrenzung: Wie alle statischen LLMs sind auch seine Trainingsdaten veraltet – es gibt kein Live-Browsing oder Abrufen.

Erste Schritte: Qwen3‑2507 selbst verwenden

Qwen3-235B-A22B-Instruct-2507 ist jetzt auf Hugging Face, OpenRouter und ModelScope verfügbar und lässt sich einfach abrufen und einsetzen.

Tipps zur Bereitstellung

- Verwenden Sie Transformatoren ≥ 4,51 oder Frameworks wie vLLM, Ollama, LMStudio und llama.cpp mit quantisierten GGUF-Modellen.

- suitable Practice für das Sampling: temperature=0,6, top_p=0,95, top_k=20.

- Ausgabelänge: Bei Aufgaben mit langem Kontext sind bis zu 16.000 oder mehr Token zulässig.

Vorschläge einfordern

Für eine einheitliche Einhaltung der Anweisungen:

- Verwenden Sie eine klare Formatierung: „Bitte befolgen Sie die Anweisungen genau. Geben Sie die endgültige Antwort in einem Absatz an.“

- Für mathematische oder mehrstufige Aufgaben: „Lösen Sie die Aufgabe Schritt für Schritt und geben Sie dann nur das Endergebnis an.“

Anwendungsfälle in der Praxis

- Wissensintensive Aufgaben: Zusammenfassungen langer Richtlinien, juristischer Begründungen oder Forschungsarbeiten.

- Programmierung: Code generieren oder überprüfen, Fehler beheben oder Aufgaben skriptbasiert automatisieren.

- Mehrsprachige Übersetzung und Qualitätssicherung in 119 Sprachen und Dialekten.

Warum Qwen3-2507 einen Fortschritt in der KI darstellt

- Open-Source-Skalierbarkeit: Bietet Funktionen, die bisher nur riesigen proprietären Modellen vorbehalten waren.

- Trennung der Funktionen: Das Instruct-Modell ist sauber von der Thinking-Variante entkoppelt, was die Bereitstellung vereinfacht.

- Zugänglichkeit: Kann vor Ort mit einer großzügigen Lizenzierung bereitgestellt werden – ideal für datenschutzbewusste und kostensensible Nutzer.

- Anwendungen mit langem Kontext: Das native 256-k-Fenster eröffnet Möglichkeiten in den Bereichen Dokumentenanalyse, Buchzusammenfassung und agentenbasierte Workflows.

- Benchmark-Dominanz: suitablee Ergebnisse in den Bereichen Schlussfolgerungen, Codierung, Mehrsprachigkeit und Abgleich in seiner Klasse.

Abschließende Gedanken und Ausblick für die Zukunft

Die Einführung von Qwen3-235B-A22B-Instruct-2507 ist ein Meilenstein: Sie beweist, dass Open-Source-Modelle modernste Leistung erzielen können und gleichzeitig zugänglich, schnell und kommerziell nutzbar bleiben. In Kombination mit der separaten Variante Qwen3-Thinking und anderen spezialisierten Qwen3-Modellen (z. B. Qwen3-Coder, Qwen3-MT) baut Alibaba ein Full-Stack-Open-Framework für KI-Innovationen auf.

Rechnen Sie mit einer weiterhin rasanten Entwicklung: Zukünftige Versionen könnten agentenbasierte Funktionen, RL-optimierte Varianten, weitere Quantisierung und umfangreichere Bereitstellungstools enthalten. Qwen3 ebnet den Weg für eine neue Wettbewerbslandschaft im Bereich der KI – eine Landschaft, in der Offenheit, Leistung und Zugänglichkeit Hand in Hand gehen.

FAQ’s

Worauf ist Qwen3‑235B‑A22B‑Instruct‑2507 spezialisiert?

Es handelt sich um ein nicht denkendes, auf Anweisungen abgestimmtes MoE-Modell, das für schnelle und genaue Antworten in den Bereichen Logik, Mathematik, Code, Allgemeinwissen und mehrsprachige Aufgaben optimiert ist.

Wie groß ist sein Kontextfenster?

Unterstützt nativ bis zu 256.144 Token.

Wie schneidet es im Vergleich zu GPT‑4o oder Claude ab?

Übertrifft GPT‑4o und DeepSeek‑V3 in den Bereichen Mathematik (AIME), GPQA, Logik (ZebraLogic) und Code-Benchmarks; liegt dicht hinter Claude Opus 4 und übertrifft dieses gelegentlich.

Ist es kostenlos und Open Source?

Ja – alle Gewichte und der gesamte Code unterliegen Apache-2.0, was eine kostenlose kommerzielle und private Nutzung ermöglicht.

Kann ich es lokal ausführen?

Ja – es wird von Frameworks wie llama.cpp, LMStudio, vLLM und mit Quantisierungsformaten wie Q4_K_XL unterstützt.