Künstliche Intelligenz verlagert sich rasch in Richtung lokaler Verarbeitung, was durch Datenschutzbedenken, schnellere Schlussfolgerungen und Unabhängigkeit von cloudbasierten APIs vorangetrieben wird. In dieser Welle der dezentralisierten KI haben zwei Plattformen die Fantasie der Community beflügelt: Ollama und LM Studio. Beide Tools erleichtern die Ausführung großer Sprachmodelle direkt vom PC aus, verfolgen jedoch unterschiedliche Ansätze. Die eine Plattform ist minimalistisch, auf Entwickler ausgerichtet und kommandozeilenbasiert, während die andere elegant, anfängerfreundlich und GUI-basiert ist. Wenn Sie sich fragen, für welche Sie sich entscheiden sollen, gibt Ihnen dieser detaillierte Vergleich zwischen Ollama und LM Studio eine klare, auf Erfahrungen basierende Antwort.

Schneller Vergleich: Die wichtigsten Unterschiede zwischen Ollama und LM Studio

| Funktion | Ollama | LM Studio |

| Benutzeroberfläche | Befehlszeilenschnittstelle (CLI) | Grafische Benutzeroberfläche (GUI) |

| Benutzerfreundlichkeit | Ideal für Entwickler | Ideal für Anfänger |

| Einrichtung und Installation | Erfordert Terminalbefehle | Plug-and-Play-Desktop-Installation |

| Anpassung | High Modelfile unterstützt erweiterte Konfiguration | Moderater Fokus auf Chat und Laden lokaler Modelle |

| Modellzugriff | Verwendet eine eigene Registrierung (ollama pull) | Direkte Verbindung mit Hugging Face |

| Leistung | Schneller und ressourceneffizienter | Etwas schwerer, aber optisch glatter |

| Integration | Einfach in Apps und Pipelines einbettbar | Beschränkt auf lokale GUI-Nutzung oder APIs |

| Open Source | Vollständig quelloffen und gemeinschaftsorientiert | Proprietär, aber kostenlos |

| Plattform-Support | macOS, Linux, Windows (preview) | macOS, Windows, Linux (beta) |

| Am geeigneten geeignet für | Entwickler, Forscher, KI-Ingenieure | Pädagogen, Schüler, Entwickler, Tester |

Ollama verstehen: Präzision und Geschwindigkeit der Befehlszeile

Ollama ist ein lokaler LLM-Runner, der bei Entwicklern, die Präzision, Flexibilität und Geschwindigkeit schätzen, sehr beliebt geworden ist. Er läuft auf einer Befehlszeilenschnittstelle (CLI), wodurch er leichtgewichtig und skriptfähig ist.

Im Gegensatz zu typischen KI-Chat-Tools, die auf Cloud-Konnektivität angewiesen sind, können Sie mit Ollama fortschrittliche Modelle wie LLaMA 2, Mistral oder Codellama direkt auf Ihrem Gerät ausführen. Es ist vollständig Open Source und basiert auf dem Backend llama.cpp, wodurch auch auf Standard-Hardware eine effiziente Inferenz gewährleistet ist.

Was Ollama wirklich auszeichnet, ist die Modelfile, eine Konfigurationsdatei, die das Verhalten des Modells definiert. Entwickler können Variationen erstellen, Systemaufforderungen zuweisen oder Persönlichkeitseinstellungen feinabstimmen. Stellen Sie sich das als „Dockerfile” lokaler LLMs vor.

Zu den wichtigsten Stärken von Ollama gehören:

- Lokale Architektur: Alle Daten werden auf Ihrem Rechner gespeichert, was die Privatsphäre verbessert.

- Schnelle Befehle: Modelle können über die CLI sofort abgerufen und ausgeführt werden.

- Flexible Integration: Perfekt für die Einbettung in benutzerdefinierte Apps oder Backend-Workflows.

- Optimierte Ausführung: Geringer Speicherbedarf und schnelle Reaktionszeit.

- Community-gesteuerte Updates: Der Open-Source-Charakter sorgt für Transparenz und Innovation.

Für Nicht-Entwickler kann das Fehlen einer grafischen Benutzeroberfläche jedoch als Hindernis empfunden werden. Die Stärke von Ollama liegt in der Kontrolle und Leistung, nicht in der Benutzerfreundlichkeit, und genau deshalb lieben Entwickler es.

Entdecken Sie LM Studio: Lokale KI visuell vereinfacht

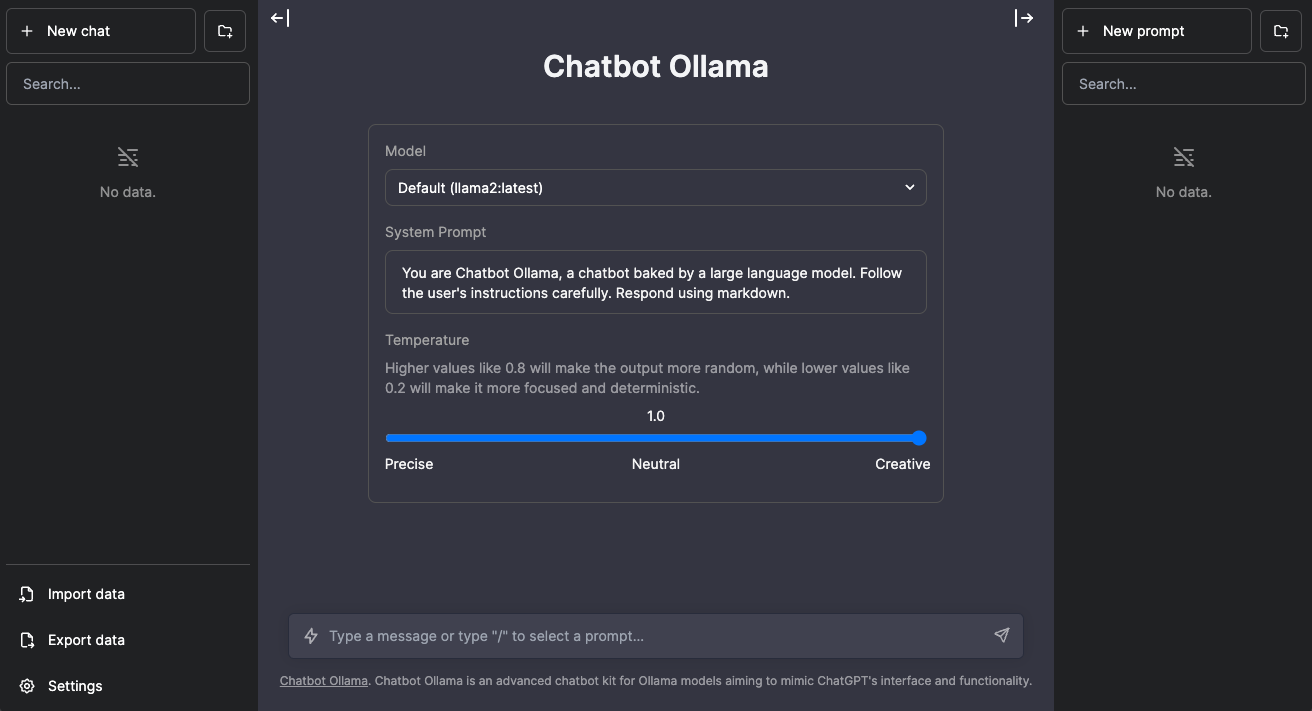

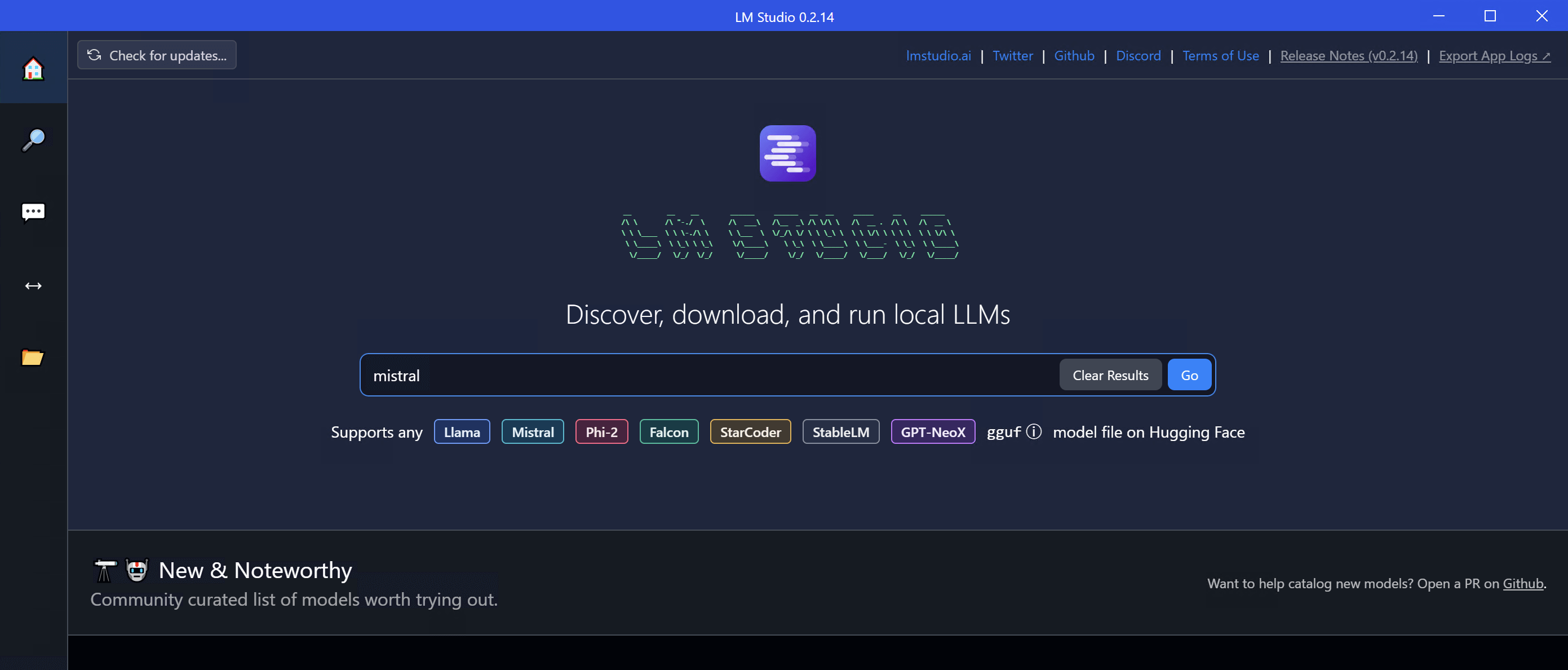

LM Studio hingegen konzentriert sich auf Barrierefreiheit und Benutzererfahrung. Dieses Tool wurde speziell als Desktop-Anwendung entwickelt, die dabei hilft, große Sprachmodelle reibungslos auszuführen.

Die grafische Benutzeroberfläche ähnelt der von ChatGPT und bietet ein übersichtliches Chat-Fenster, in dem Sie Modelle laden, mit verschiedenen Eingabeaufforderungen experimentieren und Antworten in Echtzeit analysieren können. Diese Oberfläche macht Befehlszeilenoperationen überflüssig und bietet ein geeignetens System für Benutzer, die einfach nur experimentieren möchten, ohne sich mit technischen Einstellungen auseinandersetzen zu müssen.

LM Studio lässt sich nahtlos mit Hugging Face verbinden, sodass Sie Modelle wie Mistral, LLaMA oder Vicuna direkt in der App durchsuchen und herunterladen können. Es betreibt auch einen OpenAI-kompatiblen lokalen Server, sodass Entwickler es in geeignetenhende Anwendungen integrieren können, die dieselbe API-Struktur wie OpenAI verwenden, ohne jedoch Daten an die Cloud zu senden.

Was macht LM Studio so attraktiv?

- Sofortige Einrichtung: Herunterladen, installieren und innerhalb weniger Minuten mit einem Modell chatten.

- Visuell ansprechend: Eine grafische Benutzeroberfläche, die auch für technisch weniger versierte Nutzer intuitiv zu bedienen ist.

- Hugging Face-Integration: Zugriff auf Tausende von Community-trainierten Modellen.

- Offline-Fähigkeit: Führen Sie Gespräche ohne Internetverbindung.

- API-Flexibilität: Für Entwickler, die sich eine gewisse Integrationsfreiheit wünschen.

Die größte Einschränkung geeignetenht darin, dass es auf Modellebene nicht so viele Steuerungs- und Anpassungsmöglichkeiten bietet wie Ollama. Es handelt sich eher um eine Schnittstelle zur Erkundung als um eine Plattform für die Entwicklung.

Ollama vs. LM Studio: Erfahrungen mit Installation und Einrichtung

Ollama

Die Installation von Ollama ist für Entwickler ganz einfach. Mit einem einfachen Befehl wie „brew install ollama” (unter macOS) ist es einsatzbereit, und innerhalb von Sekunden können Sie Ihr erstes Modell mit folgendem Befehl abrufen:

ollama ziehen llama2

ollama laufen llama2

Es ist schnell, minimalistisch und für die wiederholte Verwendung in Workflows konzipiert. Entwickler können es direkt in Skripte, Cron-Jobs oder vollwertige Anwendungen integrieren.

LM Studio

Im Gegensatz dazu verwendet LM Studio ein für Desktop-Anwendungen typisches Download- und Installations-Setup. Keine Befehlszeile, keine Konfigurationsdateien. Sie starten es, wählen ein Modell aus und beginnen mit dem Chatten.

Dieser Unterschied unterstreicht eine grundlegende Tatsache: Ollama unterstützt technische Anwender, während LM Studio kreative Anwender unterstützt.

Schnittstelle und Arbeitsablauf: Wie Sie interagieren, ist entscheidend

Dies ist wohl der größte Unterschied in der Debatte zwischen Ollama und LM Studio.

Die CLI von Ollama ermöglicht Automatisierung, Batch-Tests und Einbettung. Sie ist nicht auffällig, aber schnell und äußerst leistungsstark für diejenigen, die sich mit einem Terminal auskennen. Sie ist ideal für KI-Entwickler, die LLMs in Produkte oder APIs integrieren.

Die GUI von LM Studio hingegen konzentriert sich auf Komfort. Sie bietet eine dialogorientierte Erfahrung für lokale KI – ähnlich wie ChatGPT, jedoch vollständig offline. Sie können Sitzungen speichern, Modelle neu laden und Parameter visuell anpassen.

Wenn Sie also etwas entwickeln, ist Ollama die richtige Wahl. Wenn Sie sich informieren und lernen möchten, ist LM Studio die richtige Wahl.

Modellkompatibilität und Zugang

Beide Plattformen basieren auf ähnlichen Backends (llama.cpp), unterscheiden sich jedoch darin, wie Benutzer auf Modelle zugreifen und diese verwalten.

- Ollama: Unterhält ein eigenes kuratiertes Modell-Repository mit optimierten LLaMA-, Mistral- und Codellama-Builds. Mit „ollama pull“ können Sie Modelle direkt abrufen.

- LM Studio: Bietet durch die Integration von Hugging Face eine breitere Suche und ermöglicht den Zugriff auf Hunderte von Community-Modellen im GGUF-Format.

Fazit: LM Studio punktet mit seiner Vielseitigkeit, aber Ollama bietet eine sauberere Optimierung und schnellere Startzeiten.

Leistung und Optimierung

Beim Vergleich der Leistung von Ollama und LM Studio hängen die Ergebnisse oft von den Systemressourcen und den Absichten des Benutzers ab.

- Ollama führt Modelle dank seiner CLI-Architektur und intelligenten Speicherverwaltung effizient und mit minimalem Overhead aus. Es eignet sich ideal für wiederkehrende Aufgaben, Automatisierung oder die Einbettung in Backend-Systeme.

- LM Studio bietet eine stabile, flüssige Leistung, benötigt jedoch mehr GPU und RAM für die Grafikschnittstelle. Es eignet sich besser für interaktive Sitzungen als für Inferenz mit hohem Durchsatz.

Benchmarks aus Entwickler-Communities zeigen, dass Ollama durchweg schneller lädt und reagiert, insbesondere auf Linux-Systemen.

Anpassung und Entwicklerkontrolle

Wenn Sie gerne basteln, bietet Ihnen Ollama die entsprechenden Werkzeuge. Mit Modelfile können Entwickler Systemaufforderungen definieren, Token-Limits anpassen oder Modellketten erstellen. Sie können sogar die Interaktion von LLMs mit externen Datenquellen automatisieren.

LM Studio bietet hingegen ein einfacheres Konfigurationsmenü für Temperatur, Token-Länge und Systemaufforderungen, verfügt jedoch nicht über tiefgreifendere Steuerungs- oder Skriptoptionen.

Fazit: Ollama ist in puncto Anpassungsmöglichkeiten und Flexibilität für Entwickler überlegen.

Warum mögen die Leute Ollama mehr als LM Studio?

Trotz der schönen Benutzeroberfläche und der Einsteigerfreundlichkeit von LM Studio tendieren viele Entwickler und Technikbegeisterte zu Ollama, und das aus gutem Grund.

- Es ist Open Source: Transparenz schafft Vertrauen. Entwickler bevorzugen Tools, bei denen sie den Code überprüfen, Änderungen vorschlagen und Verbesserungen beitragen können.

- Leistungseffizienz: Ollama ist leichter, schneller und benötigt weniger Speicherplatz als GUI-basierte Alternativen.

- Automatisierung und Integration: Das CLI-Design ermöglicht eine nahtlose Einbettung in Apps, Pipelines oder Automatisierungsskripte, etwas, worin LM Studio noch nicht besonders gut ist.

- Entwicklerorientierte Flexibilität: Die Modelfile-Funktion ermöglicht eine umfassende Kontrolle über das Verhalten von Modellen, was mit der GUI von LM Studio nicht möglich ist.

- Unterstützung durch die Community: Die Open-Source-Community rund um Ollama wächst schnell und sorgt für häufige Updates, Patches und Modelloptimierungen.

- Plattformübergreifende Stärke: Die Linux-Unterstützung verschafft Ollama einen Vorteil bei Entwicklern und Unternehmen.

- Docker-ähnliche Vertrautheit: Entwickler, die Docker oder terminalbasierte Tools verwenden, finden sich mit der Syntax von Ollama sofort zurecht.

Einfach ausgedrückt: Ollama wirkt wie von Entwicklern für Entwickler entwickelt, während LM Studio eher für die allgemeine Erforschung der KI konzipiert zu sein scheint.

Das bedeutet nicht, dass LM Studio nicht wertvoll ist – es eignet sich hervorragend für Pädagogen, Content-Ersteller oder alle, die eine Offline-ChatGPT-Erfahrung wünschen. Aber für diejenigen, die Effizienz, Automatisierung und Open-Source-Zuverlässigkeit suchen, bietet Ollama genau das, was sie wollen.

Anwendungsfallbasierte Empfehlungen

| Anwendungsfall | Empfohlene Plattform |

| Anfänger & Pädagogen | LM Studio |

| Entwickler, die LLM-Apps erstellen | Ollama |

| Offline-Prompt-Test | LM Studio |

| Automatisierung & Pipelines | Ollama |

| Integration mit APIs oder Skripten | Ollama |

| Nicht-technische KI-Erforschung | LM Studio |

| Feinabstimmung des Modellverhaltens | Ollama |

| Leichte Einrichtung für Laptops | Ollama |

| Visuelle Interaktion für das Lernen | LM Studio |

Die Perspektive von TechNow: Lokale KI-Erfahrungen fördern

TechNow ist davon überzeugt, dass fortschrittliche Systeme wie LM Studio und Ollama die Zukunft der intelligenten KI verkörpern, in der Innovation und Automatisierung alltäglich sind.

TechNow ist darauf spezialisiert, Unternehmen beim Aufbau fortschrittlicher KI-Systeme, deren Integration mit futuristischer Technologie und der intelligenten Optimierung ihrer Abläufe zu unterstützen, was letztendlich zu einer sichereren, schnelleren und datenschutzorientierten Umgebung führt. Wenn Sie planen, Ihren Workflow zu automatisieren, ein KI-Ökosystem auf Unternehmensebene zu schaffen oder mit lokalen LLMs zu experimentieren, ist TechNow die geeigneten Wahl.

Denn in der Welt der KI ist die Wahl des richtigen Tools eine strategische Entscheidung. Mit TechNow an Ihrer Seite sind Sie immer einen Schritt voraus.

Die Perspektive von TechNow: Lokale KI-Erfahrungen fördern

Die Wahl zwischen Ollama und LM Studio hängt letztendlich davon ab, was Ihnen am wichtigsten ist: Kontrolle oder Komfort.

Unabhängig davon, ob Sie sich mit technischer Forschung, Webentwicklung oder einfach nur mit der technischen Nutzung beschäftigen, jeder braucht Flexibilität, und in dieser Hinsicht ist Ollama immer der klare Gewinner. Es bietet Ihnen eine schnellere, einfache Integration und Open-Source-Tools in einer komplexen Arbeitsumgebung. Sie können Ihre Arbeit skripten, skalieren und sogar nach Ihren Bedürfnissen gestalten.

Für die lokale KI-Erforschung finden Menschen, die eine übersichtliche, visuelle und chatähnliche Oberfläche wünschen, LM Studio in seiner Einfachheit unschlagbar. Es ist, als hätte man sein eigenes Offline-ChatGPT, ohne sich um Datenschutz oder Abonnements kümmern zu müssen.

Beide sind beeindruckend, richten sich jedoch an unterschiedliche Denkweisen.